Алексей

Алексей

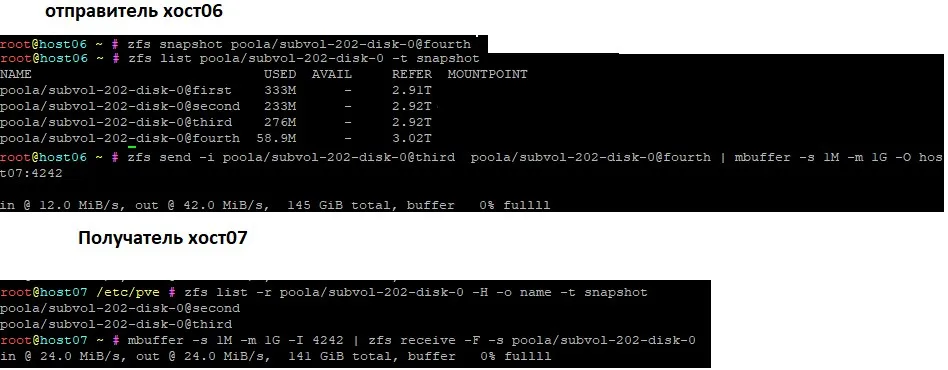

ребята привет, есть вопрос почему когда инкрементально переношу снапшот размером несколько сотен мегабайт, зфс сенд передает несколько десятков гигабайт? дедупликации нет.

Сергей

Сергей

Сергей

Сергей

Сергей, спасибо. а почему передалось в итоге 150?

не знаю точно, возможно с учётом компрессии разжалось в больший объём

Сергей

Сергей

но честно говоря, если бы Георгий посмотрел, то это было бы точнее чем мои предположения. Я тоже далеко не настоящий сварщик))

Сергей

Сергей

Может он инкремент между ними сделать не смог и перетащил целиком с родителем

но вроде send делался на машине, где были все снапшоты. Т.е. у него recieve мог "сломаться", а для send были все исходные данные.

George

George

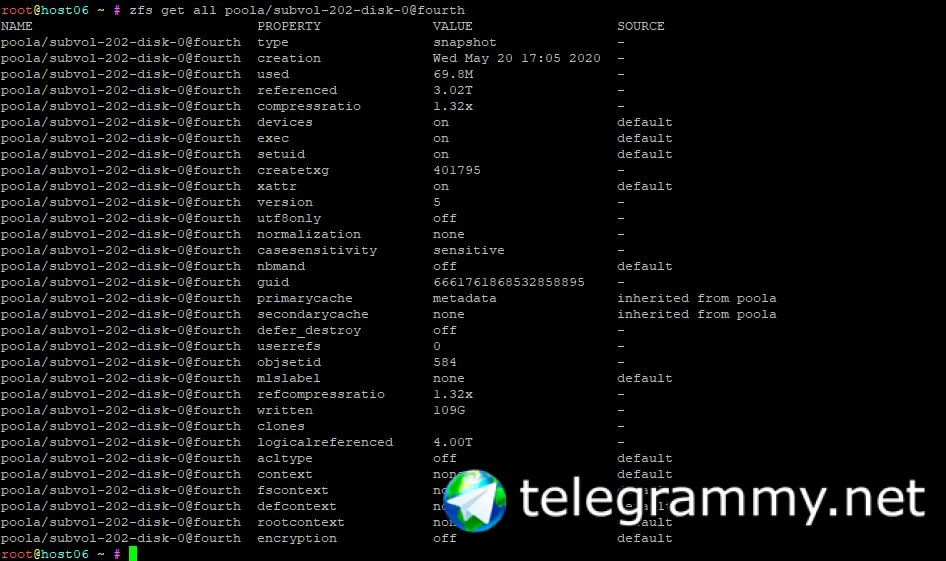

впринципе 109 видно по столбцу REFER при выводе zfs list -t snapshot

да, по дефолту send передаёт данные as is без сжатия, т.е. возможны и экстремальные сценарии когда у вас в 2000 раз пожато - получите x2000 по объёму

Fedor

Fedor

2020 May 22 22:02:54, load: 1.19, disk_r: 120 KB, disk_w: 456900 KB

UID PID PPID CMD DEVICE MAJ MIN D BYTES

0 0 0 sched sd6 194 384 R 12288

0 0 0 sched sd7 194 448 R 32768

0 0 0 sched blkdev0 31 17 R 77824

0 121 0 zpool-data blkdev0 31 17 W 14831616

0 121 0 zpool-data sd7 194 448 W 42332160

0 121 0 zpool-data sd8 194 512 W 42332160

0 121 0 zpool-data sd11 194 704 W 44294144

0 121 0 zpool-data sd12 194 768 W 44294144

0 121 0 zpool-data sd10 194 640 W 45125632

0 121 0 zpool-data sd9 194 576 W 45125632

0 121 0 zpool-data sd3 194 192 W 45637632

0 121 0 zpool-data sd4 194 256 W 45637632

0 121 0 zpool-data sd5 194 320 W 51953664

0 121 0 zpool-data sd6 194 384 W 51953664

Сергей

Сергей

а если всех подключенных по iscsi клиентов отключить запись продолжается? или нет возможности остановить targetd?

Fedor

Fedor

по самой скази написал ванлайнер - за минуту сбора инфы говорит, что трафик в пике мегабайт в секунду с пары машин.

Сергей

Сергей

ну чтобы полностью исключить что это не от клиентов. может там от клиентов приходит "килобайт" по айскази, а это превращается в поток обращений на комстаровском zfs к дискам

Fedor

Fedor

Tracing... Hit Ctrl-C to end.

^C

REMOTE IP EVENT COUNT Kbytes KB/sec

172.16.. read 3 56 2

172.16.. read 5 84 3

172.16.. read 5 160 6

172.16.. write 1569 17808 688

172.16.. write 1746 19097 738

172.16.. write 3104 39770 1537

real 0m27.134s

Fedor

Fedor

но при этом

# zpool iostat data 1

capacity operations bandwidth

pool alloc free read write read write

---------- ----- ----- ----- ----- ----- -----

data 20.5T 15.8T 277 2.76K 1.14M 34.3M

data 20.5T 15.8T 17 3.13K 71.9K 49.5M

data 20.5T 15.8T 0 2.67K 0 33.6M

data 20.5T 15.8T 0 762 4.00K 10.8M

data 20.5T 15.8T 0 126 4.00K 1.81M

data 20.5T 15.8T 0 130 4.00K 1.94M

data 20.5T 15.8T 0 2.77K 4.00K 45.1M

data 20.5T 15.8T 0 4.19K 3.99K 51.4M

data 20.5T 15.8T 0 357 0 7.61M

Сергей

Сергей

я понимаю, по 45-50мб/с. targetd совсем потушить нельзя, да? комстар только под раздачу по айскази?

Олег

Олег

Vladislav

Vladislav

Евгений

Евгений