Vladimir

Vladimir

“A scheduled job creates a job object about once per execution time of its schedule. We say “about” because there are certain circumstances where two jobs might be created, or no job might be created. We attempt to make these rare, but do not completely prevent them. Therefore, jobs should be idempotent.”

Я правильно понимаю, что “оно может сработать, может не сработать, может сработать два раза. Вы уже не обесудьте” ?

Anonymous

Anonymous

а еще мне непонятно что значит в данном контексте "должны быть идемпотентны": это "мы ниче не обещаем вы сами следите чтобы нужная джоба во второй раз не запускала снова тот же таск, кешируйте там или я хз"?

Anonymous

Anonymous

или "да, мы понимаем что все должно быть красиво... в следующих релизах поправим"

Vladimir

Vladimir

ну вот AWS Lambda говорят, что сработает как минимум один раз. То есть может быть и два, но чтобы не сработало быть не может. То есть, если идемпотентная функция, то должно быть норм.

С кубернетесом я так понял идемпотентность не поможет, ибо может вообще не выполниться.

Dmitry

Dmitry

ну вот AWS Lambda говорят, что сработает как минимум один раз. То есть может быть и два, но чтобы не сработало быть не может. То есть, если идемпотентная функция, то должно быть норм.

С кубернетесом я так понял идемпотентность не поможет, ибо может вообще не выполниться.

Это проблема вообще всех похожих систем. Нету очереди такой, что бы гарантировала именно ОДНУ доставку сообщения, а не КАК МИНИМУМ ОДНУ

Rayan

Rayan

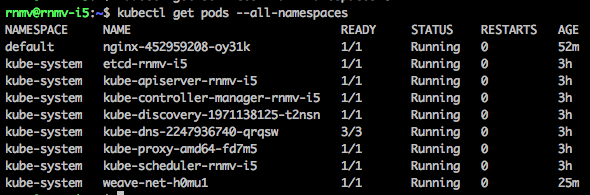

rnmv@rnmv-i5:~$ kubectl get svc

NAME CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes 100.64.0.1 <none> 443/TCP 3h

nginx 100.64.7.221 <pending> 80/TCP 7m

уже почти 3 минуты на pending... После выполнения kubectl expose deployment nginx --port 80 --type LoadBalancer. Что может быть не так?

Etki

Etki

А как шедулеры будут реализованы? Они распределенные? Там есть какие-то гарантии?

я даже не заглядывал в спеку, но kubernetes держит один активный мастер и хранит все в etcd, тут по-моему особых вариантов-то нет.

Dmitry

Dmitry

Всем привет! Ребят, хочу совета спросить у тех, кто использует deis workflow. Как вы считаете лучше "поделить" апп на тест, стейдж и прод окружения?

Dmitry

Dmitry

Anonymous

Anonymous

кстати, официальный репозиторий с helm начали заполнять: https://github.com/kubernetes/charts

Dmitry

Dmitry

Почему не использовать? по мне так хорошая штука для билда и деплоя

Он очень ограниченный. Но если тебе нужно задеплоить вордпрес, то наверное пойдет. В других случаях нужно использовать kubernetes

Dmitry

Dmitry

окай =) я учту, что ничего сложного лучше через deis не заливать. Вопрос-то в другом, есть те, кто использует и как разбивают на test/stage/prod =)

Михаил

Михаил

уф, спецы, подскажите, есть openshift пытаюсь скрестить его с jenkins

прописал апи, ключ, проект, пытаюсь создать деплоймент конфиг через дженкинс, а оно мне в ответ в логах

resourceVersion may not be set on objects to be created

Dmitry

Dmitry

согласен.. Если разбить на 3 отдельных кластера, то должно быть не плохо.. И деис повесить только на тестовые окружения... Хмм.

Pasha Chalyk

Pasha Chalyk

никто не сталкивался с такой ошибкой?

[root@srv-333770 ~]# kubectl version

Client Version: version.Info{Major:"1", Minor:"3", GitVersion:"v1.3.7", GitCommit:"a2cba278cba1f6881bb0a7704d9cac6fca6ed435", GitTreeState:"clean", BuildDate:"2016-09-12T23:15:30Z", GoVersion:"go1.6.2", Compiler:"gc", Platform:"linux/amd64"}

error: failed to negotiate an api version; server supports: map[], client supports: map[federation/v1beta1:{} autoscaling/v1:{} extensions/v1beta1:{} policy/v1alpha1:{} batch/v1:{} batch/v2alpha1:{} authentication.k8s.io/v1beta1:{} v1:{} authorization.k8s.io/v1beta1:{} componentconfig/v1alpha1:{} apps/v1alpha1:{} rbac.authorization.k8s.io/v1alpha1:{}]

Pasha Chalyk

Pasha Chalyk

[root@blabla]# export GOOGLE_APPLICATION_CREDENTIALS="path-to-key-json"

[root@blabla]# gcloud container clusters get-credentials cluster-name --zone zone-name

a1ch3m

a1ch3m

Всем добра в этом чате)

#whois

▫️Какой у вас проект или где работаете?

Израильский стартап по очистке ecommerce трафика

▫️В чём вы специалист?

DevOps, sysop, etc. 10+ лет опыта

▫️Чем можете быть интересны или полезны сообществу?

Делиться опытом использования k8s

▫️Чем интересно сообщество вам?

Инетресен опыт использования k8s на высоких нагрузках

▫️Откуда вы?

Израиль

▫️Как узнали про группу?

гугл: telegram kubernetes

M

M

чат, а у кого в логах контроллера видно такие ошибки

E0928 09:38:44.970618 1 deployment_controller.go:400] Error syncing deployment static-namespace/static: Operation cannot be fulfilled on deployments.extensions "static": the object has been modified; please apply your changes to the latest version and try again

?

a1ch3m

a1ch3m

@exename c ошибкой не сталкивался, но выкатываю версию не через apply, а через

rolling-update $K8S_RC_NAME --image=$PROJECT_IMAGE --namespace=production --image-pull-policy=IfNotPresent --update-period=0s

kay

kay

cat nginx_extra_conf.yaml

apiVersion: v1

metadata:

name: nginx-ingress-controller

data:

body-size: "4G"

kind: ConfigMap

kay

kay

$ cat ingress_daemonset.yaml | grep -C1 nginx-ingress-controller

args:

- /nginx-ingress-controller

- --default-backend-service=$(POD_NAMESPACE)/default-http-backend

- --nginx-configmap=$(POD_NAMESPACE)/nginx-ingress-controller

kay

kay

У меня вот так логи выглядят:

76.72.167.90 - [76.72.167.90] - - [28/Sep/2016:14:41:01 +0000] "GET / HTTP/1.1" 200 4199 "-" "Pingdom.com_bot_version_1.4_(http://www.pingdom.com/)" 168 0.004 10.64.62.3:8000 14770 0.004 200

Alexander

Alexander