Alexey

Alexey

Когда ноду удалишь, через MaaS ее можно зачистить, он диски на нем форматнет все.

а при add unit он не затерает его ?

Alexey

Alexey

Когда ноду удалишь, через MaaS ее можно зачистить, он диски на нем форматнет все.

эту я видел настройку

Yuriy

Yuriy

а при add unit он не затерает его ?

Он перезаписывает поверх только системный диск. Если на ноде еще ceph диски были, лучше пройтись перед add-unit.

Alexey

Alexey

Yuriy

Yuriy

Может быть такое что когда Ceph будешь инсталить на ноду, там скрипт обругается, что не может законфигурировать диски, придеться ручками фигачить.

Yuriy

Yuriy

Может быть такое что когда Ceph будешь инсталить на ноду, там скрипт обругается, что не может законфигурировать диски, придеться ручками фигачить.

Хотя может сейчас скрипт допилили уже.

Yuriy

Yuriy

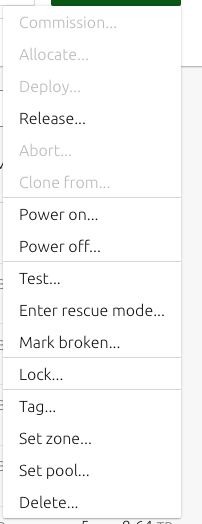

После remove-unit он у тебя встанет в статус ready и realease доступен не будет.

Поэтому ее нужно будет перевести в статус Allocate.

Yuriy

Yuriy

Короче, конмады... 8)))

juju remove-unit nova-compute/{unit-id}

juju remove-unit ceph-osd/{unit-id}

juju remove-machine {machine-id}

Yuriy

Yuriy

Потом в MaaS находишь эту ноду - Allocate, потом Release с очисткой диска. Бутаешь ноду через PXE. Ждешь когда MaaS все там форматнет.

Андрей

Андрей

Добрый день при создании роутера

[root@controller ~]# openstack router create test-router

NotFoundException: Not Found, The resource could not be found.

[root@controller ~]#

В логах code 404: PecanNotFound, кто то сталкивался с подобным?

2023-02-14 16:16:42.229 17406 WARNING neutron.pecan_wsgi.controllers.root [req-68d14e90-81c4-4d38-a2b7-2e7f28e82e2c 888a78edc1f24f569b9c1e1e6f031877 6e614164330643a59574d4df10565f6a - default default] No controller found for: routers - returning response code 404: PecanNotFound

2023-02-14 16:16:42.233 17406 INFO neutron.pecan_wsgi.hooks.translation [req-68d14e90-81c4-4d38-a2b7-2e7f28e82e2c 888a78edc1f24f569b9c1e1e6f031877 6e614164330643a59574d4df10565f6a - default default] POST failed (client error): The resource could not be found.

2023-02-14 16:16:42.234 17406 INFO neutron.wsgi [req-68d14e90-81c4-4d38-a2b7-2e7f28e82e2c 888a78edc1f24f569b9c1e1e6f031877 6e614164330643a59574d4df10565f6a - default default] 127.0.0.1 "POST /v2.0/routers HTTP/1.1" status: 404 len: 309 time: 0.2447429

Timofey

Timofey

kolla берет эти конфиги /usr/local/share/kolla-ansible/ansible/roles/neutron/templates/ml2_conf.ini.j2 ?

если нет ironic'а то vlan'ы включаются коллой через мердж конфигов.

в папке с конфигами для коллы у меня есть

kolla $ ls etc/kolla/config/neutron/*

etc/kolla/config/neutron/ml2_conf.ini

kolla $ cat etc/kolla/config/neutron/*

[ml2_type_vlan]

network_vlan_ranges = physnet1:1000:2000%

Андрей

Андрей

root@controller:~# apt list --installed | grep neutron

neutron-common/now 2:11.0.8-6~u16.04+mcp278 all [installed,local]

neutron-dynamic-routing-common/now 2:11.0.0-2~u16.04+mcp2 all [installed,local]

neutron-lbaas-common/now 2:11.0.4-2~u16.04+mcp11 all [installed,local]

neutron-lbaasv2-agent/now 2:11.0.4-2~u16.04+mcp11 all [installed,local]

neutron-linuxbridge-agent/now 2:11.0.8-6~u16.04+mcp278 all [installed,local]

neutron-metadata-agent/now 2:11.0.8-6~u16.04+mcp278 all [installed,local]

neutron-openvswitch-agent/now 2:11.0.8-6~u16.04+mcp278 all [installed,local]

neutron-plugin-linuxbridge-agent/now 2:11.0.8-6~u16.04+mcp278 all [installed,local]

neutron-plugin-ml2/now 2:11.0.8-6~u16.04+mcp278 all [installed,local]

neutron-plugin-openvswitch-agent/now 2:11.0.8-6~u16.04+mcp278 all [installed,local]

neutron-server/now 2:11.0.8-6~u16.04+mcp278 all [installed,local]

python-neutron/now 2:11.0.8-6~u16.04+mcp278 all [installed,local]

python-neutron-dynamic-routing/now 2:11.0.0-2~u16.04+mcp2 all [installed,local]

python-neutron-fwaas/now 2:11.0.2-3~u16.04+mcp10 all [installed,local]

python-neutron-fwaas-dashboard/now 1.0.0-1~u16.04+mcp2 all [installed,local]

python-neutron-lbaas/now 2:11.0.4-2~u16.04+mcp11 all [installed,local]

python-neutron-lbaas-dashboard/now 3.0.1-1~u16.04+mcp2 all [installed,local]

python-neutron-lib/now 1.9.1-2~u16.04+mcp11 all [installed,local]

python-neutron-lib-doc/now 1.9.1-2~u16.04+mcp11 all [installed,local]

python-neutronclient/now 1:6.5.0-1~u16.04+mcp23 all [installed,local]

python3-neutron-lib/now 1.9.1-2~u16.04+mcp11 all [installed,local]

python3-neutronclient/now 1:6.5.0-1~u16.04+mcp23 all [installed,local]

Андрей

Андрей

ovs-vsctl show

9bc52021-619a-46b8-a2b0-080f2c4605d3

Manager "ptcp:6640:127.0.0.1"

is_connected: true

Bridge br-ex

Controller "tcp:127.0.0.1:6633"

is_connected: true

fail_mode: secure

Port phy-br-ex

Interface phy-br-ex

type: patch

options: {peer=int-br-ex}

Port br-ex

Interface br-ex

type: internal

Port "eno2"

Interface "eno2"

Bridge br-tun

Controller "tcp:127.0.0.1:6633"

is_connected: true

fail_mode: secure

Port "gre-c0a80159"

Interface "gre-c0a80159"

type: gre

options: {df_default="true", in_key=flow, local_ip="192.168.1.17", out_key=flow, remote_ip="192.168.1.89"}

Port br-tun

Interface br-tun

type: internal

Port patch-int

Interface patch-int

type: patch

options: {peer=patch-tun}

Bridge br-int

Controller "tcp:127.0.0.1:6633"

is_connected: true

fail_mode: secure

Port patch-tun

Interface patch-tun

type: patch

options: {peer=patch-int}

Port int-br-ex

Interface int-br-ex

type: patch

options: {peer=phy-br-ex}

Port "tap95bb9e91-67"

tag: 1

Interface "tap95bb9e91-67"

type: internal

Port br-int

Interface br-int

type: internal

ovs_version: "2.6.1"

NS 🇷🇺

NS 🇷🇺

Андрей

Андрей

в конфиге нейтрона что прописано в плугинах?

neutron.conf

[DEFAULT]

core_plugin = ml2

transport_url = rabbit://openstack:openstack@controller

auth_strategy = keystone

service_plugin = router

allow_overlapping_ips = True

notity_nova_on_port_status_changes = True

notity_nova_on_port_data_changes = True

ipam_driver = internal

[agent]

root_helper = sudo /usr/bin/neutron-rootwrap /etc/neutron/rootwrap.conf

[database]

connection = mysql+pymysql://neutron:neutron@controller/neutron

[keystone_authtoken]

project_name = service

user_domain_name = default

project_domain_name = default

auth_type = password

username = neutron

password = openstack

auth_uri = http://controller:5000

auth_url = http://controller:35357

memcached_servers = controller:11211

[oslo_concurrency]

lock_path = /var/lib/neutron/tmp

Андрей

Андрей

ml2_conf.ini

[ml2]

type_drivers = local,flat,gre,vlan,vxlan

tenant_network_type = gre

mechanism_drivers = openvswitch,l2population

[ml2_type_gre]

tunnel_id_ranges = 1:1000

[securitygroup]

enable_security_group = True

enable_ipset = True

Андрей

Андрей

порт 9696 открыт и прослушивается

curl -vv http://controller:9696

* Rebuilt URL to: http://controller:9696/

* Trying 127.0.1.1...

* Connected to controller (127.0.1.1) port 9696 (#0)

> GET / HTTP/1.1

> Host: controller:9696

> User-Agent: curl/7.47.0

> Accept: */*

>

< HTTP/1.1 200 OK

< Content-Length: 119

< Content-Type: application/json

< Date: Tue, 14 Feb 2023 14:28:59 GMT

<

* Connection #0 to host controller left intact

{"versions": [{"status": "CURRENT", "id": "v2.0", "links": [{"href": "http://controller:9696/v2.0/", "rel": "self"}]}]

Artemy

Artemy

Блин ну вот смотрю на всю эту хрень с деплоями то через мегаансиблы, то через коллы и жужи и охреневаю. Ну вот нафига?! Неужели это так сложно - поставить на хост пакеты и залить конфиги сервисов самым простым способом который вы знаете, вписав в него IP хоста?

gwaewion

gwaewion

Блин ну вот смотрю на всю эту хрень с деплоями то через мегаансиблы, то через коллы и жужи и охреневаю. Ну вот нафига?! Неужели это так сложно - поставить на хост пакеты и залить конфиги сервисов самым простым способом который вы знаете, вписав в него IP хоста?

Я чуть смузи мятным латтэ не поперхнулся

Timofey

Timofey

Блин ну вот смотрю на всю эту хрень с деплоями то через мегаансиблы, то через коллы и жужи и охреневаю. Ну вот нафига?! Неужели это так сложно - поставить на хост пакеты и залить конфиги сервисов самым простым способом который вы знаете, вписав в него IP хоста?

Да!!! Даешь наливку конфигов на все n-цать нод руками! к черту темплэйты и всякая автоматизация!!