потому что варя кинула всех ?)

я не копаюсь в чужом грязном белье

Dmitry

Dmitry

Maksimus Ulibikus

Maksimus Ulibikus

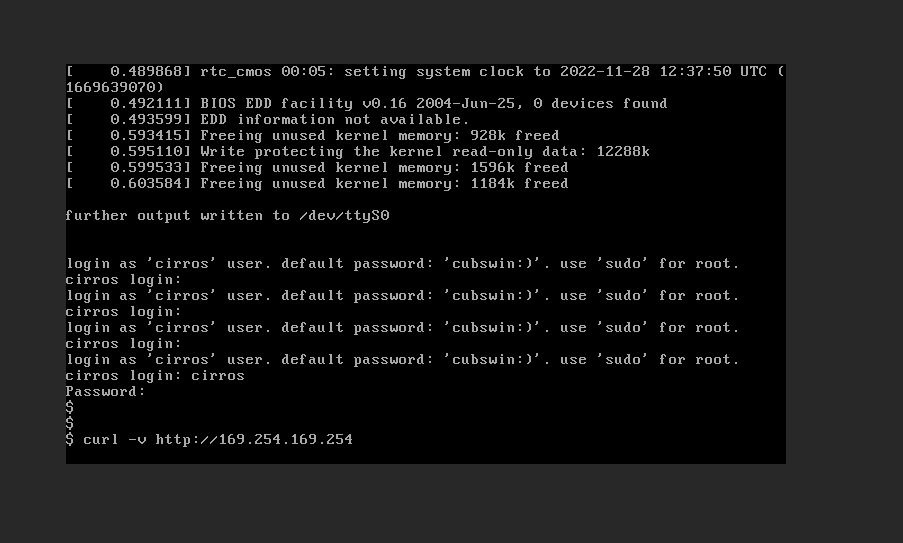

Парни, помогите с этой метадатой. Не получается настроить.

Инстанс добавил роут 169.254.169.254

[ 32.860500] cloud-init[995]: Cloud-init v. 22.3.4-0ubuntu1~18.04.1 running 'init' at Mon, 28 Nov 2022 12:08:14 +0000. Up 21.83 seconds.

[ 32.864680] cloud-init[995]: ci-info: +++++++++++++++++++++++++++++++++++++++Net device info+++++++++++++++++++++++++++++++++++++++

[ 32.887280] cloud-init[995]: ci-info: ++++++++++++++++++++++++++++++++Route IPv4 info++++++++++++++++++++++++++++++++

[ 32.889265] cloud-init[995]: ci-info: +-------+-----------------+-------------+-----------------+-----------+-------+

[ 32.891243] cloud-init[995]: ci-info: | Route | Destination | Gateway | Genmask | Interface | Flags |

[ 32.893210] cloud-init[995]: ci-info: +-------+-----------------+-------------+-----------------+-----------+-------+

[ 32.895126] cloud-init[995]: ci-info: | 0 | 0.0.0.0 | 10.10.85.1 | 0.0.0.0 | enp3s0 | UG |

[ 32.897032] cloud-init[995]: ci-info: | 1 | 10.10.85.0 | 0.0.0.0 | 255.255.255.0 | enp3s0 | U |

[ 32.898898] cloud-init[995]: ci-info: | 2 | 169.254.169.254 | 10.10.85.11 | 255.255.255.255 | enp3s0 | UGH |

[ 32.900755] cloud-init[995]: ci-info: +-------+-----------------+-------------+-----------------+-----------+-------+

10.10.85.11 - контроллер. Но почему контроллер не добавляет себе в роут 169.254.169.254?

В логах dhcp-agent говорит - я типа слушаю вас:

2022-11-28 15:17:40.936 10132 DEBUG neutron.agent.metadata.driver [-] haproxy_cfg =

global

log /dev/log local0 debug

log-tag haproxy-metadata-proxy-c2ac31ff-8d88-4e1b-bbb6-814a75311f46

user neutron

group neutron

maxconn 1024

pidfile /var/lib/neutron/external/pids/c2ac31ff-8d88-4e1b-bbb6-814a75311f46.pid.haproxy

daemon

defaults

log global

mode http

option httplog

option dontlognull

option http-server-close

option forwardfor

retries 3

timeout http-request 30s

timeout connect 30s

timeout client 32s

timeout server 32s

timeout http-keep-alive 30s

listen listener

bind 169.254.169.254:80

server metadata /var/lib/neutron/metadata_proxy

http-request del-header X-Neutron-Router-ID

http-request set-header X-Neutron-Network-ID c2ac31ff-8d88-4e1b-bbb6-814a75311f46

NS 🇷🇺

NS 🇷🇺

Maksimus Ulibikus

Maksimus Ulibikus

ну ты из инстанса сделал хотя бы запрос по адресу? трафик подампил?

Нет запроса и не пингуется. И, скажем, IP инстанса 10.10.85.15, у инстанса роут 169.254.169.254 | 10.10.85.11, но с 10.10.85.15 на 10.10.85.11 не идёт пинг, потому что контроллер 10.10.85.11 не знает сети 169.254.0.0

NS 🇷🇺

NS 🇷🇺

Maksimus Ulibikus

Maksimus Ulibikus

на вм есть роут?

Да

| 2 | 169.254.169.254 | 10.10.85.11 | 255.255.255.255 | enp3s0 | UGH |

Maksimus Ulibikus

Maksimus Ulibikus

покажи конфиг агента

# cat /etc/neutron/dhcp_agent.ini | egrep -v "(^#.*|^$)"

[DEFAULT]

interface_driver = linuxbridge

dhcp_driver = neutron.agent.linux.dhcp.Dnsmasq

enable_isolated_metadata = true

enable_metadata_network = true

force_metadata = true

debug = true

NS 🇷🇺

NS 🇷🇺

Aleksandr драствуйте. Вы там свою нашлепку что ли для терраформа написали? или просто обернули существующий опенстек провайдер?

Maksimus Ulibikus

Maksimus Ulibikus

ip a, ip r из dhcp немспейса еще покажи

# ip netns exec qdhcp-c2ac31ff-8d88-4e1b-bbb6-814a75311f46 ip r

default via 10.10.85.1 dev ns-3efc729c-c0 proto static

10.10.85.0/24 dev ns-3efc729c-c0 proto kernel scope link src 10.10.85.11

[root@os-controller-01 ~(keystone)]# ip netns exec qdhcp-c2ac31ff-8d88-4e1b-bbb6-814a75311f46 ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ns-3efc729c-c0@if6: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default qlen 1000

link/ether fa:16:3e:cc:b7:46 brd ff:ff:ff:ff:ff:ff link-netnsid 0

inet 169.254.169.254/32 brd 169.254.169.254 scope global ns-3efc729c-c0

valid_lft forever preferred_lft forever

inet 10.10.85.11/24 brd 10.10.85.255 scope global ns-3efc729c-c0

valid_lft forever preferred_lft forever

inet6 fe80::a9fe:a9fe/64 scope link

valid_lft forever preferred_lft forever

inet6 fe80::f816:3eff:fecc:b746/64 scope link

valid_lft forever preferred_lft forever

NS 🇷🇺

NS 🇷🇺

Maksimus Ulibikus

Maksimus Ulibikus

curl -v http://169.254.169.254 с инстанса и с агента

[root@os-controller-01 ~(keystone)]# curl -v http://169.254.169.254

* Rebuilt URL to: http://169.254.169.254/

* Trying 169.254.169.254...

* TCP_NODELAY set

* connect to 169.254.169.254 port 80 failed: Connection timed out

* Failed to connect to 169.254.169.254 port 80: Connection timed out

* Closing connection 0

curl: (7) Failed to connect to 169.254.169.254 port 80: Connection timed out

NS 🇷🇺

NS 🇷🇺

J

J

Не, я правую кружку имею ввиду

И я.

Без воды целую чашку (0.25-0.37) крепкого эспрессо тяжело пить.

Valeriy

Valeriy

И я.

Без воды целую чашку (0.25-0.37) крепкого эспрессо тяжело пить.

Но как ещё админить эти ваши опенстеки? ))

Dmitry

Dmitry

я вот знаю много людей из этого чата, у которых ставка сильно больше 20 баксов в час =) даже на фриланс

J

J

это точно чат высокоплачивыемых/квалифицированных инженеров? =)

А что тебя сомневаться заставило?)

Dmitry

Dmitry

А что тебя сомневаться заставило?)

ну с радужными какашками и картинками с трипами - это ок. но наливать шампанское в бокал для игристого - это кажется подозрительным

J

J

ну с радужными какашками и картинками с трипами - это ок. но наливать шампанское в бокал для игристого - это кажется подозрительным

ААААА, мы задумку не поняли.

То, может, не вода, а шампанское)

Maksimus Ulibikus

Maksimus Ulibikus

Yuriy

Yuriy

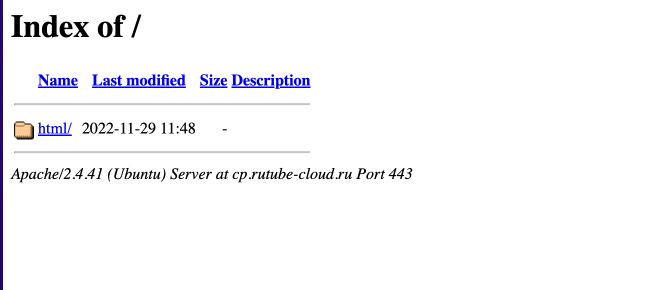

в апаче рут каталог надо указать кто то знает как это сделать через juju

https://charmhub.io/openstack-dashboard

Alexey

Alexey

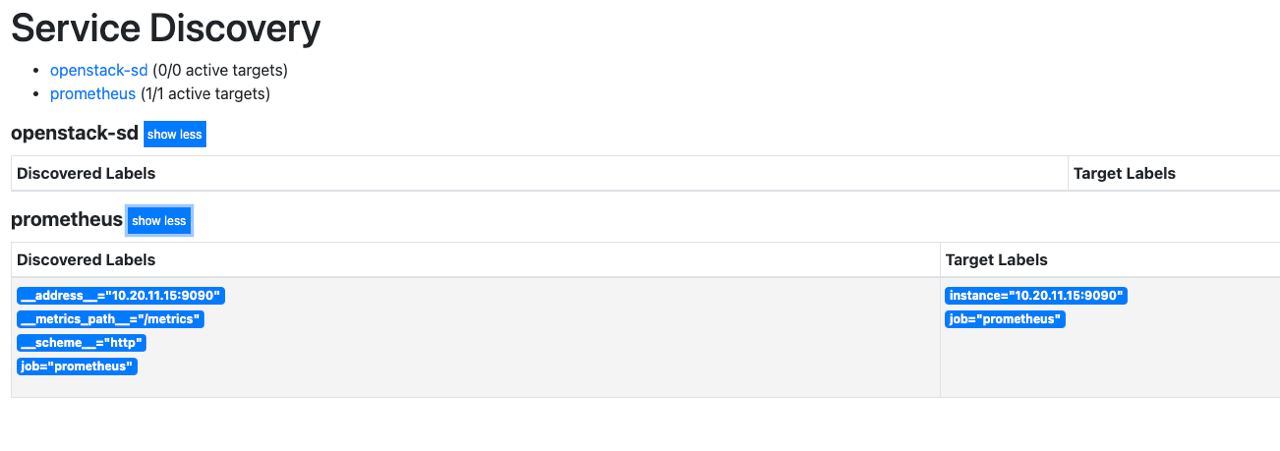

# my global config

global:

scrape_interval: 15s # Set the scrape interval to every 15 seconds. Default is every 1 minute.

evaluation_interval: 15s # Evaluate rules every 15 seconds. The default is every 1 minute.

# scrape_timeout is set to the global default (10s).

# Alertmanager configuration

alerting:

alertmanagers:

- static_configs:

- targets:

# - alertmanager:9093

# Load rules once and periodically evaluate them according to the global 'evaluation_interval'.

rule_files:

# - "first_rules.yml"

# - "second_rules.yml"

# A scrape configuration containing exactly one endpoint to scrape:

# Here it's Prometheus itself.

scrape_configs:

# The job name is added as a label `job=` to any timeseries scraped from this config.

- job_name: 'prometheus'

static_configs:

- targets: ['10.20.11.15:9090']

- job_name: 'openstack-sd'

openstack_sd_configs:

- identity_endpoint: https://keystone.domain.ru:5000/v3

username: admin

project_id: b26a2f710e4747bb842ea026b5fbac9d

password: eewii2ahMo7ahmah

role: instance

region: RegionOne

domain_name: admin_domain

# port: 9100

tls_config:

insecure_skip_verify: true

Den

Den

Oleksandr

Oleksandr

Василий

Василий

Denis

Denis

Pavel

Pavel

Pavel

Pavel