мне кажется, самый понимаемый кейс - добавить новый /24 сабнет в паблик сеть без добавления новой сети

это ж пару кликов, нет ?

Steelshark

Steelshark

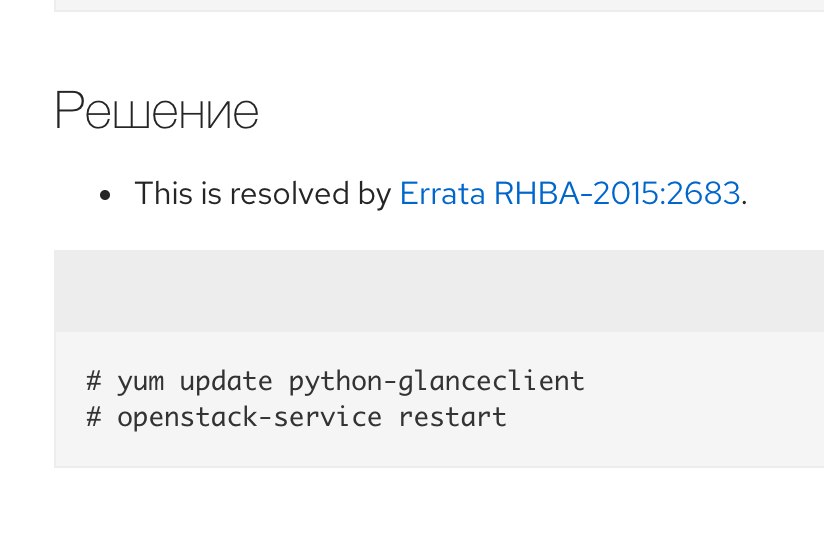

я как понял ни у кого идей по моим имеджам нет) у кого-нибудь есть доступ к knowladgebase redhat?

там вроде есть солюшены, но посмотреть не дает

https://access.redhat.com/solutions/2144941

J

J

мне кажется, самый понимаемый кейс - добавить новый /24 сабнет в паблик сеть без добавления новой сети

Ну или еще из того что могу придумать это случай когда тебе не хочется плодить идентификаторы новые для протокола куда инкапсулируется трафик self-service нейтрон сети.

Ну типа не плодить VNI для Geneve или VXLAN, Tunnel id для GRE или VLAN ID, если у тебя по какому-то недоразумению self-service во вланы заворачиваются.

Fedor

Fedor

Fedor

Fedor

я как понял ни у кого идей по моим имеджам нет) у кого-нибудь есть доступ к knowladgebase redhat?

там вроде есть солюшены, но посмотреть не дает

https://access.redhat.com/solutions/2144941

там всегда охуеннные решения. но можно им сказать, что ты разработчик и дают доступ бесплатно

J

J

сложна, но можна)

Ну а чо, если у тебя очень большое облако и сложная какая-то схема маршрутизации трафика внутри него, то желание минимизировать количество разных идентификаторов эт естественно.

Меньше разных циферок в которых надо ориентироваться - чуть легче железу и гораздо легче тебе если что-то случится)

NS 🇷🇺

NS 🇷🇺

я как понял ни у кого идей по моим имеджам нет) у кого-нибудь есть доступ к knowladgebase redhat?

там вроде есть солюшены, но посмотреть не дает

https://access.redhat.com/solutions/2144941

проверьте конфиг циндера и гленса, они тупо у вас не видят друг друга… точнее не могут друг в друга.

Steelshark

Steelshark

там вообще много ответов

https://access.redhat.com/search/#/?q=cinder%20Can't%20create%20volume%20from%20image&p=1&sort=relevant&scoped&documentKind=Knowledgebase&article_type=Solution

Fedor

Fedor

Ну а чо, если у тебя очень большое облако и сложная какая-то схема маршрутизации трафика внутри него, то желание минимизировать количество разных идентификаторов эт естественно.

Меньше разных циферок в которых надо ориентироваться - чуть легче железу и гораздо легче тебе если что-то случится)

а потом как шторм туда приехал от отключенного порт сесурити на одной вмке, где очень было надо, и все как удивились да? :)

Fedor

Fedor

проверьте конфиг циндера и гленса, они тупо у вас не видят друг друга… точнее не могут друг в друга.

ну и логи, cinder-api cinder-volume и гланса

J

J

Илья | 😶☮️🐸

Илья | 😶☮️🐸

Steelshark

Steelshark

ну и логи, cinder-api cinder-volume и гланса

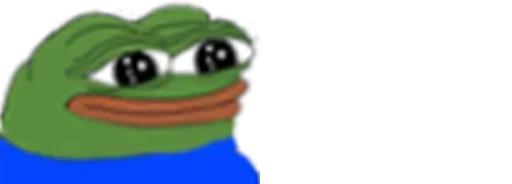

в microstack несколько проще, там столько логов нет..но гленс все ок говорит, а циндер имерж не может

Steelshark

Steelshark

ща опять напишут, что в логах ничего нет =)

вообще-то я дебаг выше приекрепил и лог тоже)

Ask

Ask

Илья | 😶☮️🐸

Илья | 😶☮️🐸

Ask

Ask

а что не так то ?

Все сети к роутеру не подключить, только у одной подсети может быть включена дхсп. Ну и кажется так проще в управлении когда к одной сети одна подсеть принадлежит.

Илья | 😶☮️🐸

Илья | 😶☮️🐸

Все сети к роутеру не подключить, только у одной подсети может быть включена дхсп. Ну и кажется так проще в управлении когда к одной сети одна подсеть принадлежит.

а несколько сетей могут принадлежать к одному provider ?

Pavel Mashkov

Pavel Mashkov

вообще-то я дебаг выше приекрепил и лог тоже)

какой glance_api_servers стоит в конфиге циндера и какой у гланса?

openstack endpoint list | grep glance

Steelshark

Steelshark

какой glance_api_servers стоит в конфиге циндера и какой у гланса?

openstack endpoint list | grep glance

в microstack я нигде не нашел данную конфигурацию. так что никакие

NS 🇷🇺

NS 🇷🇺

да с какой радости оно там будет называться по другому… там тот же стек с базовы набором компонетов

Pavel Mashkov

Pavel Mashkov

можете показать как эти переменные в двух конфигах задаются?

https://docs.openstack.org/cinder/rocky/configuration/block-storage/samples/cinder.conf.html

Pavel Mashkov

Pavel Mashkov

можете показать как эти переменные в двух конфигах задаются?

вывод

openstack endpoint list | grep glance

дай

Steelshark

Steelshark

root@openstack:/var/snap/microstack/common# microstack.openstack endpoint list | grep glance

| 9921675c94974f6194f5cd772580ff8a | microstack | glance | image | True | internal | https://192.168.11.33:9292 |

| c09ee49ee06e4db5a6bb9db8a6cf2574 | microstack | glance | image | True | public | https://192.168.11.33:9292 |

| fad0d8a3b9a54017ab245c1dc71760d0 | microstack | glance | image | True | admin | https://192.168.11.33:9292 |

Илья | 😶☮️🐸

Илья | 😶☮️🐸

Steelshark

Steelshark

в общем добавил в конфиг синдера, та же хрень..

glance_api_servers = https://192.168.11.33:9292

Steelshark

Steelshark

Вот меня что смущает, мы пишем, что будем обращаться по поводу имеджа на гленс, а идем на синдер, кто-нибудь может попробовать у себя диск сделать и дебаг прислать, я хоть посмотрю различия

GET call to image for https://192.168.11.33:9292/v2/images/e0dca105-a492-4c4e-99a1-c9ee57cbad2c used request id req-0c2b2b0c-3240-4e3a-8a03-917ab9d72384

REQ: curl -g -i --cacert "/var/snap/microstack/common/etc/ssl/certs/cacert.pem" -X POST https://192.168.11.33:8776/v3/591a2faf09ef4967bbb6182190983f32/volumes -H "Accept: application/json" -H "Content-Type: application/json" -H "User-Agent: python-cinderclient" -H "X-Auth-Token: {SHA256}9480ec3f90773c7d4b220a8a54bc319177018f8a435f41314d015780243d8bfb" -d '{"volume": {"size": 20, "consistencygroup_id": null, "snapshot_id": null, "name": "mytest", "description": null, "volume_type": null, "availability_zone": "nova", "metadata": {}, "imageRef": "e0dca105-a492-4c4e-99a1-c9ee57cbad2c", "source_volid": null, "backup_id": null}}'

Starting new HTTPS connection (1): 192.168.11.33:8776

https://192.168.11.33:8776 "POST /v3/591a2faf09ef4967bbb6182190983f32/volumes HTTP/1.1" 400 105

Artemy

Artemy

Проверил что имадж такой существует и доступен чтобы синдер зря не дергать, и потом отправил создавать волюм

Artemy

Artemy

в общем добавил в конфиг синдера, та же хрень..

glance_api_servers = https://192.168.11.33:9292

А ему это не особо и нужно - в каталоге вся информация нужная должна быть

Den

Den

Доброго. Пользователи создали проект, в нем шифрованные тома, и удалили проект. Есть элегантный способ удалить эти тома? А то барбикан лесом посылает.

В итоге создал новые пользователя и проект. Лапками в БД поправил им ИД на нужные, назначил права и спокойно удалил. А теперь так сделать всего-то 20 раз 😅

Andrey

Andrey

Кто как чистит в колле кеш гланса? image_cache_dir =

Из доки.

The recommended practice is to use cron to fire glance-cache-pruner at a regular interval.

Почистил руками.

Не нашел ничего в ansible-kolla, может плохо искал.

Den

Den

В итоге создал новые пользователя и проект. Лапками в БД поправил им ИД на нужные, назначил права и спокойно удалил. А теперь так сделать всего-то 20 раз 😅

Ну так что бы было и уже до конца. Пользователя не обязательно создавать. Меняем ИД проекта, выдаем админу права на этот проект, удаляем тома, снимаем права. И снова меняем ИД в базе.

Денис

Денис

Народ, подскажите, пожалуйста, есть у меня сингл нода с openstack, домашний тестовый стенд, есть 1 нвме под систему и 3 свободных ssd evo 870, сейчас использую только 1 ssd под lvm, вот не знаю как лучше распорядиться двумя оставшимися дисками, хотел на ceph мини-кластер наскребсти, но слишком мало дисков, какой рейд лучше здесь использовать, мне резервирование не очень нужно, насколько strip lvm будет надежно работать в контексте домашней лабы?

J

J

Народ, подскажите, пожалуйста, есть у меня сингл нода с openstack, домашний тестовый стенд, есть 1 нвме под систему и 3 свободных ssd evo 870, сейчас использую только 1 ssd под lvm, вот не знаю как лучше распорядиться двумя оставшимися дисками, хотел на ceph мини-кластер наскребсти, но слишком мало дисков, какой рейд лучше здесь использовать, мне резервирование не очень нужно, насколько strip lvm будет надежно работать в контексте домашней лабы?

Сколько людей будет советовать столько схем посоветуют.

Скажу что рейды с отказоустойчивостью на SSD это бессмысленная идея за редкими исключениями.

Попили всё на пару VG. Одна для эфемерных дисков, а вторая для всего остального что захочешь.

Денис

Денис

Кастомную vg под эфемерки? Пока не понимаю, у меня kolla, и насколько я помню, там qcow2 создаются внутри контейнера nova_libvirt, хранятся в overlay2 в docker volume. Имеется ввиду, выделить из одной vg логический том под весь /var/lib/docker или же размапить этот логический том конкретно под bind volume для libvirt конейнера для всех создаваемых эфемерных?

Vyacheslav

Vyacheslav

Кастомную vg под эфемерки? Пока не понимаю, у меня kolla, и насколько я помню, там qcow2 создаются внутри контейнера nova_libvirt, хранятся в overlay2 в docker volume. Имеется ввиду, выделить из одной vg логический том под весь /var/lib/docker или же размапить этот логический том конкретно под bind volume для libvirt конейнера для всех создаваемых эфемерных?

у вас всё равно в capacity будет весь диск, а не выгородка

J

J

J

J

суть понятна, спасибо, разделить на эфемерные и синдер диски вроде как неплохая идея

Идея в том чтоб не делать рейдов, короче, и просто объединить емкость всех дисков.

А как уже всё это делить дело десятое.

Vyacheslav

Vyacheslav

Идея в том чтоб не делать рейдов, короче, и просто объединить емкость всех дисков.

А как уже всё это делить дело десятое.

ух класно будет если 1 диск вылетит без рейда

NS 🇷🇺

NS 🇷🇺

ух класно будет если 1 диск вылетит без рейда

так же классно будет, как он у тебя вылетит в домашнем софтрейде

Vyacheslav

Vyacheslav

так же классно будет, как он у тебя вылетит в домашнем софтрейде

если это RAID1 то ничего не сломается

NS 🇷🇺

NS 🇷🇺

Шо я 1 дома использую страйп?)))

Судя по всему не один у меня zfs страйпом 3 диска... А почему не raidz да потому что банально нецелесообразно выкидывать 4тб

Andrey

Andrey

Обнаружил, что иногда долго отрабатывает запрос. Медленно отдают разные контролы. Если запускать руками стабильно каждый 6,7 раз долго, такое ощущение если быстро то из кеша. Очень мешает отдавать данные через openstack_exporter. Может кто посоветует что-нибудь. Как это продебажить.

Victoria, сеть OVN, около 100 гиперов

```

openstack network agent list --timing

+-----------------------------------------------+----------+

| URL | Seconds |

+-----------------------------------------------+----------+

| GET http://172.22.4.255:35357/v3 | 0.188738 |

| POST http://172.22.4.255:35357/v3/auth/tokens | 0.315684 |

| GET http://172.22.4.255:9696/v2.0/agents | 0.3443 |

| Total | 0.848722 |

+-----------------------------------------------+----------+

+-----------------------------------------------+--------------------+

| URL | Seconds |

+-----------------------------------------------+--------------------+

| GET http://172.22.4.255:35357/v3 | 0.101769 |

| POST http://172.22.4.255:35357/v3/auth/tokens | 0.442599 |

| GET http://172.22.4.255:9696/v2.0/agents | 21.573399 |

| Total | 22.117766999999997 |

+-----------------------------------------------+--------------------+

```

Andrey

Andrey

в идеале чтобы время везде было синхронизировано

chrony везде стоит и работает, но вот 4-5 минут есть