Ну так я потому от пакетов и отказался что мейнтейнеры нихуя не следят за выходящими фиксами и не обновляют пакеты месяцами.

Если не пакеты, то что?

Сергей

Сергей

Так, всё, Opennebula наше всё! https://www.youtube.com/watch?v=47Mht_uoX3A&feature=youtu.be 🙂

J

J

Если не пакеты, то что?

Собранные из репозиториев venv или контейнеры, но контейнеры для подобных вещей эт не моя тема.

J

J

Собранные из репозиториев venv или контейнеры, но контейнеры для подобных вещей эт не моя тема.

Ну или свои пакеты делать, но это плохая идея, замучаешься с зависимостями.

Михаил

Михаил

Сергей

Сергей

Я шучу. Но мне понравилась серия докладов от Андрея Квапила, в которой он делится как он построил хостинг компанию с kubernetes over LTSP и vm over OpenNebula в Чехии что ли. Делится горой технических подробностей и причинами принятия решений. https://habr.com/ru/post/423785/ и его видео об этом https://www.youtube.com/watch?v=yGKI5JoKMUY&feature=youtu.be. Цитата: "открытых проектов под данные задачи 2: openstack и opennebula. Openstack это 20 миллинов строчек кода и документация в виде Read The Fucking Sources. Opennebula состоит из 200 тысяч строк кода и документация у неё отличная." Интересно поглядеть поближе на драйверы на bash 🙂

NS 🇷🇺

NS 🇷🇺

Serhii

Serhii

Есть ещё cloud stack

чёт не видел раньше чтобы его ставили на равне с OpenStack / OpenNebula

пробовал?

NS 🇷🇺

NS 🇷🇺

чёт не видел раньше чтобы его ставили на равне с OpenStack / OpenNebula

пробовал?

Тогда ещё все в переди

J

J

Я шучу. Но мне понравилась серия докладов от Андрея Квапила, в которой он делится как он построил хостинг компанию с kubernetes over LTSP и vm over OpenNebula в Чехии что ли. Делится горой технических подробностей и причинами принятия решений. https://habr.com/ru/post/423785/ и его видео об этом https://www.youtube.com/watch?v=yGKI5JoKMUY&feature=youtu.be. Цитата: "открытых проектов под данные задачи 2: openstack и opennebula. Openstack это 20 миллинов строчек кода и документация в виде Read The Fucking Sources. Opennebula состоит из 200 тысяч строк кода и документация у неё отличная." Интересно поглядеть поближе на драйверы на bash 🙂

Чудны дела твои, Господи!

Парень с одной стороны молодец, а с другой, будто бы, просто не хочет разбираться в сложном софте, поэтому "легко кастомизируется, ну я и написал на баше чудо-патчи"

Denis

Denis

Может кому будет полезно: HPE Reference Architecture for Red Hat OpenStack Platform on HPE Synergy with Ceph Storage - https://h20195.www2.hpe.com/V2/GetDocument.aspx?docname=a00071087enw

Я и твой кот

Я и твой кот

Hello

Hello

Искренне надеюсь, что за джуниорские вопросы отсюда не гонят ссаными тряпками. Имеется rocky на трёх физических машинах: один контроллер, две компьют ноды. Не заводятся инстансы, ругается нейтрон. Говорит что не может забиндить порт под инстанс, если я его правильно понял. ERROR neutron.plugins.ml2.managers [req- ... - default default] Failed to bind port ... on host compute1 for vnic_type normal using segments [{'network_id': '...', 'segmentation_id': None, 'physical_network': u'provider', 'id': '...', 'network_type': u'flat'}]. ... - айди соответствующих сущностей. Уверен, что причина максимально тривиальна, и заключается в моей криворукости, поскольку установка вся проводилась на чистых системах, строго по мануалу с офсайта, минимальномый деплой. Предполагаю, что проблема в настройке самого нейтрона, поскольку мануал прерывается на том, что все заработало, и как правилно создавать сети внутри проекта написано недостаточно явно(либо я плохо искал). Спасибо, если прочитали, и хорошего понедельника!

Maksim

Maksim

Искренне надеюсь, что за джуниорские вопросы отсюда не гонят ссаными тряпками. Имеется rocky на трёх физических машинах: один контроллер, две компьют ноды. Не заводятся инстансы, ругается нейтрон. Говорит что не может забиндить порт под инстанс, если я его правильно понял. ERROR neutron.plugins.ml2.managers [req- ... - default default] Failed to bind port ... on host compute1 for vnic_type normal using segments [{'network_id': '...', 'segmentation_id': None, 'physical_network': u'provider', 'id': '...', 'network_type': u'flat'}]. ... - айди соответствующих сущностей. Уверен, что причина максимально тривиальна, и заключается в моей криворукости, поскольку установка вся проводилась на чистых системах, строго по мануалу с офсайта, минимальномый деплой. Предполагаю, что проблема в настройке самого нейтрона, поскольку мануал прерывается на том, что все заработало, и как правилно создавать сети внутри проекта написано недостаточно явно(либо я плохо искал). Спасибо, если прочитали, и хорошего понедельника!

ограничь интерфейс для VNC консоли в nova-compute.conf

У нас такое было, когда порт для VNC выделялся на всех интерфейсах, а не только на интерфейсе виртуалки

Hello

Hello

Hello

Hello

Hello а тут что ?

# cat /etc/neutron/plugins/ml2/ml2_conf.ini | grep mechanism_drivers

mechanism_drivers = linuxbridge

Hello

Hello

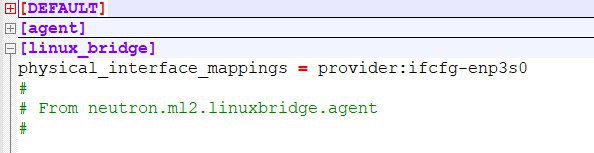

а в конфиге linuxbridge_agent.ini physical_interface_mappings ?

physical_interface_mappings = provider:enp3s0

Hello

Hello

ограничь интерфейс для VNC консоли в nova-compute.conf

У нас такое было, когда порт для VNC выделялся на всех интерфейсах, а не только на интерфейсе виртуалки

[vnc]

enabled=true

server_listen= ip моего сервера

server_proxyclient_address= ip моего сервера

Я правильно вас понял?

Vadim

Vadim

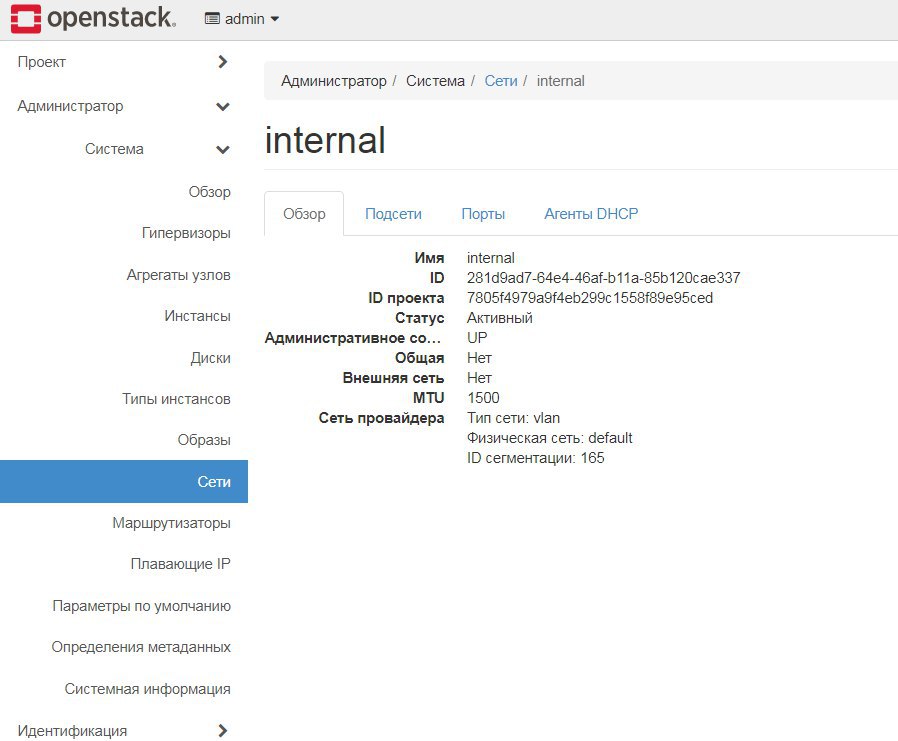

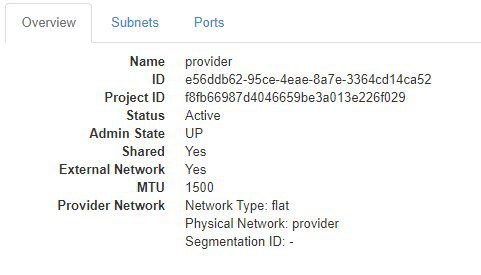

если октрыть сеть, в которую подключаетесь, в horizon под админом, скиньте скрин первой вкладки

Maksim

Maksim

Hello

Hello

Vadim

Vadim

нужно включить debug=true в neutron.cong, и попробоавть еще воспроизвести, и скиньте логи в pastbin, например

Hello

Hello

Hello

Hello

Hello 👍

это, кстати, самая часта причина) поэтому с маппинга начинаю смотреть всегда

Я причем был абсолютно уверен, что проверил там уже все три раза. Но вот когда не нашел linuxbridge-agent.log на ноде - понял что что-то не так.. Ещё раз спасибо!

J

J

Привет, ребята.

Подскажите по винде. Я где-то, наверное, нахуевертил с cloudbase-init - после ребилда инстансов с виндой то ли метаданные не обновляются новым паролем то ли уже существующий в метаданных cloudbase-init игнорирует.

И получается что нужно пересоздавать, а не просто ребилд делать.

Vadim

Vadim

https://superuser.openstack.org/articles/rebuilding-an-openstack-instance-and-keeping-the-same-fixed-ip/

Anton

Anton

Коллеги, обнаружили неприятную особенность виртуализации ovirt/openstack.. если запустить tcpdump то сбрасывается в ноль net.ipv4.conf.eth0.forwarding = 0

На том интерфейсе, на котором запускали tcpdump

Andrey

Andrey

Andrey

Andrey

хотя да, если вспомнить что опенстек создали в наса, а все наши беды от америкосов - то все сходится)

J

J

Коллеги, обнаружили неприятную особенность виртуализации ovirt/openstack.. если запустить tcpdump то сбрасывается в ноль net.ipv4.conf.eth0.forwarding = 0

На том интерфейсе, на котором запускали tcpdump

А что за система? Версия ядра и тип виртуальной сетевушки?

Andrey

Andrey

Коллеги, обнаружили неприятную особенность виртуализации ovirt/openstack.. если запустить tcpdump то сбрасывается в ноль net.ipv4.conf.eth0.forwarding = 0

На том интерфейсе, на котором запускали tcpdump

самое быстрое что могу предложить - попробуйте обновить tcpdump - вы же, к стати, все эти вещи внутри ВМ делаете ?

Anton

Anton

Примечание: systemd-networkd (Русский) предоставляет новую семантику пересылки в версии 220/221. [1] Если вы используете systemd-networkd для управления сетевыми интерфейсами, оно перекроет настройки net.*.ip_forward, по умолчанию выключив пересылку. Чтобы оно принимало вышеописанные настройки, нужно задать IPForward=kernel в конфигурационном файле интерфейса systemd-networkd (смотрите systemd.network(5) для дополнительной информации).

J

J

причина замечательна, systemd обвес пытаются сделать слишком умным.

Ёбаный говна кусок, в каждом релизе подлянка.

Tamerlan

Tamerlan

Ёбаный говна кусок, в каждом релизе подлянка.

>Ёбаный говна кусок

so far это мой опыт с опенстаком в целом

J

J

>Ёбаный говна кусок

so far это мой опыт с опенстаком в целом

Ну да.

Но опенстек эт опенстек.

А systemd-networkd эт критичный теперь уже компонент ОС.

NS 🇷🇺

NS 🇷🇺

Ну да.

Но опенстек эт опенстек.

А systemd-networkd эт критичный теперь уже компонент ОС.

RHEL 8 выкинули его нахрен =)

Dmitry

Dmitry