https://docs.openstack.org/ocata/networking-guide/deploy.html

Спасибо!

Artem

Artem

https://docs.openstack.org/mitaka/networking-guide/config-bgp-dynamic-routing.html

В данном случае, получается l3 agent один и на контроллере ?

Alexander

Alexander

Спасибо!

Да не за что! В Nova, например, забыли упомянуть про Nova Placement, патч находится на рассмотрении: https://review.openstack.org/#/c/438328/

Alexander

Alexander

В данном случае, получается l3 agent один и на контроллере ?

Не специалист в BGP, но похоже на то

Serega

Serega

> https://docs.openstack.org/ocata/networking-guide/deploy.html

Выглядит страшно...

Если нужен именно BGP-пиринг с инфраструктурой -- посмотрите в сторону Calico.

Artem

Artem

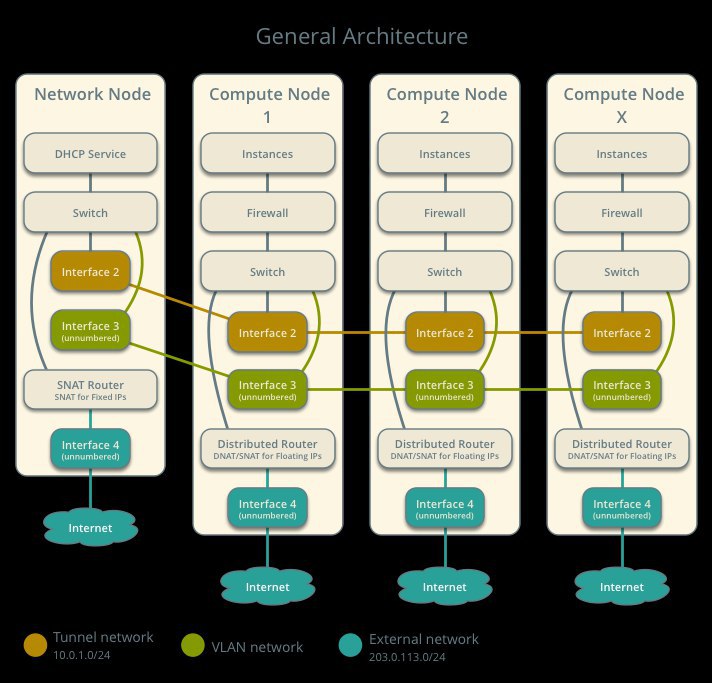

Нетворк-нода является анахронизмом со времен, когда не было всяких NFV и DVR

А примеры для openstack есть ?

Vyacheslav

Vyacheslav

А примеры для openstack есть ?

Примеры чего? Чтобы далеко не ходить, поробуйте MOS со включенным DVR.

Artem

Artem

Примеры чего? Чтобы далеко не ходить, поробуйте MOS со включенным DVR.

Mos, это что - mirantis openstack? И расшифруйте, что есть dvr?

Vyacheslav

Vyacheslav

кстати как вообще MOS/fuel для средне-масштабного продакшена на десяток нод?

тестируется до 200 нод

citius

citius

я вообще в openstack новый, раньше все всфера да всфера. поссмотрел, в хорайзоне кучи нужных фич нету (или не видно во всяком случае), например лайв-миграцию как я понял надо руками впиливать

Vyacheslav

Vyacheslav

Mike

Mike

live миграцию делает админ, в его аккаунте. Обычный пользователь не может воспользоваться таким функционалом, по умолчанию

Vyacheslav

Vyacheslav

live миграцию делает админ, в его аккаунте. Обычный пользователь не может воспользоваться таким функционалом, по умолчанию

обычный пользователь вообще не должен работать с физическими ресурсами

Mike

Mike

И не надо сравнивать, пожалуйста VMware и OpenStack. Системы создавались под разные задачи и подход изначально был разный

Mike

Mike

обычный пользователь вообще не должен работать с физическими ресурсами

я лишь ответил про миграцию и её наличиее в dashboard

citius

citius

> Vyacheslav

Все равно все свою вебку прикручивают

ну вот это я под "руками" и имел в виду.

Vyacheslav

Vyacheslav

т.е. еще что-то прогать надо чтобы оно удобно ехало.

для Private Cloud сгодится то что есть

Artem

Artem

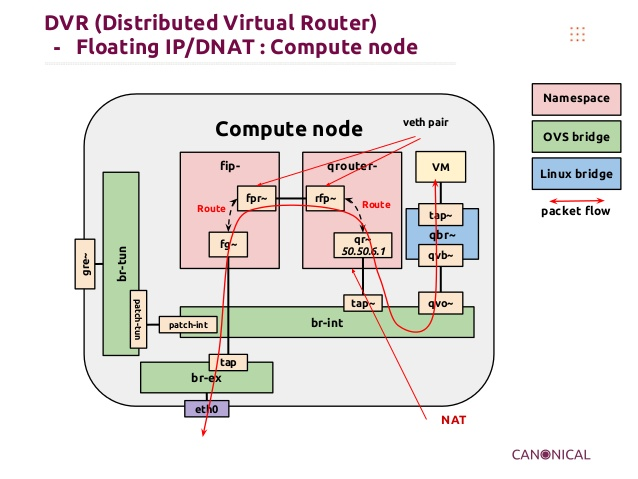

Я вот что в DVR не понимаю, там роутеры с одинаковыми ип адресами на интерфейсах, каким чудом оно работает?

NS 🇷🇺

NS 🇷🇺

NS 🇷🇺

NS 🇷🇺

Artem

Artem

Мм, в плане что qrouter с Compute01 не знает ничего о qrouter c Compute02. А уникальность только на уровне floating-ip?

Artem

Artem

ну а в чем проблема? все верно сказали, linux namespaces (аналог VRF в сетевых железках)

Так а floating-ip все равно с network ноды обслуживаются?

Artem

Artem

В общем, если я правильно понял, чтобы DVR работал.

На compute01 вешаем floating на DVR - 10.10.0.1

На сompute02 вешаем floating на DVR - 10.10.0.2

instance01 на compute01 имеет floating ip 10.10.0.5 для него есть маршрут на внешнем роутере, типа ip route 10.10.0.5 via 10.10.0.1

Когда падает compute01 маршрут меняется на 10.10.0.5 via 10.10.0.2

Artem

Artem

Я так понимаю маршрутизация не в ведении openstack? типа делаем все руками? Или подключаем BGP, https://docs.openstack.org/mitaka/networking-guide/config-bgp-dynamic-routing.html

Artem

Artem

вы же compute nodes не сразу в роутер включаете

А как, схема говорит сразу в интернет, в этом магия DVR ?

Vadim

Vadim

VM которая хочет пойти в другую сетку спросит mac шлюза, в int бридже трафик завернут в роутер

NS 🇷🇺

NS 🇷🇺

Расскажите это разработчикам опенстека, где при использовании ДВР, на каждом компуте создается фип неймспейс, если на этом компуте есть хотя бы одна машина с фип

Artem

Artem

потом он смаппится в уникальный fip для конкретного neutron порта и улетит во вне

А как он обратно себе дорогу найдет? Я почти понял и почти опять все не понял

Artem

Artem

Вот у меня есть DVR 10.10.0.1 и 10.10.0.2. В какой то момент instance01 с ip 10.10.0.10 переехал на 10.10.0.2. Получается что трафик должен прийти на 10.10.0.2, оттуда он SNATится и уходит уже по маку. Потому что между всеми compute есть L2

Vadim

Vadim

The DVR agent takes responsibility for creating, updating, or deleting the routers in the router namespaces. For all clients in the network owned by the router, the DVR agent populates the ARP entry. By pre-populating ARP entries across compute nodes, the distributed virtual router ensures traffic goes to the correct destination.

Artem

Artem

Ну так правильно с нее трафик без проблем убегает, а как он с интернета к ней то путь находит?

Artem

Artem

Пограничный маршрутизатор:

ip route add 10.10.0.10 via 10.10.0.1

—------------------------------------------------—

Compute01 - 10.10.0.1 is down

Compute02 - 10.10.0.2 up

\ instance01 10.10.0.10 is up (compute02)

Danila

Danila