Inferno solutions

Да их знаю. есть проблема.

Alexey Mishurovskiy

Alexey Mishurovskiy

Ну как мне сказала поддержка VLAN у них нет. и единственное решение поставить выделенные сервера

Alexey Mishurovskiy

Alexey Mishurovskiy

Есть такое дерево сущностей:

Агент

Клиент1

Пост 1

Коммент1

Соответственно у Агента может быть много Клиентов, у Клиентов может быть много постов, у Постов может быть много комментов

Задача вывести для Агента таблицу:

Клиент, Кол-во Постов, Кол-во комментов

и чтобы по кол-ву постов и комментов можно было сортировать.

Юра

Юра

Удачи

Рабочее решение если нужно много делать селектов и мало апдейтов и не важна супер констистентость

Alexey Mishurovskiy

Alexey Mishurovskiy

Я бы добавил агрегационную таблицу которую обновлял кроном

Вопрос в том какие держать актуальной

Сергей

Сергей

Ну так напиши)))

ну если в таблицах не по миллиону записей, то можно просто всё заджоинить, сгруппировать по клиенту и отсортировать.

Andrey

Andrey

ну если в таблицах не по миллиону записей, то можно просто всё заджоинить, сгруппировать по клиенту и отсортировать.

Человеку больше кроном нравится

Andrey

Andrey

Ну а масштабы хоть какие? Ну типа сколько может быть Клиентов, постов комментов у одного Агента? А то вдруг там по 100к постов и 1кк комментов и там тогда запрос точно никак не поможет

Юра

Юра

Ок а если там пару миллионов коментов предлагаете каждый раз делать груп бай каунт на всей таблице?

Andrei

Andrei

так пока никто не писал про миллионы комментов то) Задача поставлена в исходной формулировке как тест на собесе на знание SQL для джуна)

Andrey

Andrey

Ок а если там пару миллионов коментов предлагаете каждый раз делать груп бай каунт на всей таблице?

Евентами в коде обновлять таблицу со счётчиками... Или тригерры или ещё что то вроде редиса...

Andrei

Andrei

давайте пофантазируем. Если у автора действительно там много комментов то 1) Если это отчет в какой нить интерпрайз системе, то скорее всего его редко юзают и вполне пойдет sql с группировкой. 2) Если это какая то страничка со сводными данными на дашборде - тупо закешируйте ответ, и остатется 1% случаев когда действительно нужно денормализовать, например в ту же материальную вьюху

Alexey Mishurovskiy

Alexey Mishurovskiy

так пока никто не писал про миллионы комментов то) Задача поставлена в исходной формулировке как тест на собесе на знание SQL для джуна)

Ну на счет задачки для джуна это ты бощенул чот )

Andrey

Andrey

Кароч... Задачка эта делается как проще и быстрее... А потом когда начнёт тупить - переписывается нормально... На фиг этот оверинжинеринг...

Alexey Mishurovskiy

Alexey Mishurovskiy

Короче решил делать предагрегаты, еще добавлю дату туда. буду хранить кол-во по дням, чтобы удобно было строить потом отчеты день\неделя, месяц и т.д.

Andrei

Andrei

Я к тому что простой и надежный как топор запрос с агрегацией, даже с сотнями записей на группу, при правильных индексах будет выполняться за десятые доли секунды. Если у вас там нагрузка на метод не десятки и сотни rps, то стоит ли городить огород?

Alexey Mishurovskiy

Alexey Mishurovskiy

Ну скажем так запрос в любом случае делать и он будет одинаковый фактически и для прямого вывода и для предагрегата, так что начну с запроса, а дальше видно будет как работает. благо можно наполнить тестовыми данными в любом количестке

Katulos

Katulos

Джентльмены, пытаюсь с помощью https://symfony.com/doc/current/components/dom_crawler.html распарсить таблицу. Умеет ли данный компонент выбрать определенное количество элементов, а не всю таблицу? Если да, то каким образом?

Alexander

Alexander

Но в целом не вижу проблемы получить все элементы и дальше отрезать или отфильтровать нужное кол-во

Katulos

Katulos

Но в целом не вижу проблемы получить все элементы и дальше отрезать или отфильтровать нужное кол-во

Оно довольно таки тяжелое, не хотелось бы забивать память

Andrey

Andrey

Оно довольно таки тяжелое, не хотелось бы забивать память

Тогда лучше вообще отказаться от DomCrawler

Alexander

Alexander

Альтернативы?

Миллион их.

Память не хочется забивать потому что 10000rpm на бекенд или по идеологическим причинам?

По моему опыту домкраулеры в один поток работают.

Andrey

Andrey

Andrey

Andrey

Миллион их.

Память не хочется забивать потому что 10000rpm на бекенд или по идеологическим причинам?

По моему опыту домкраулеры в один поток работают.

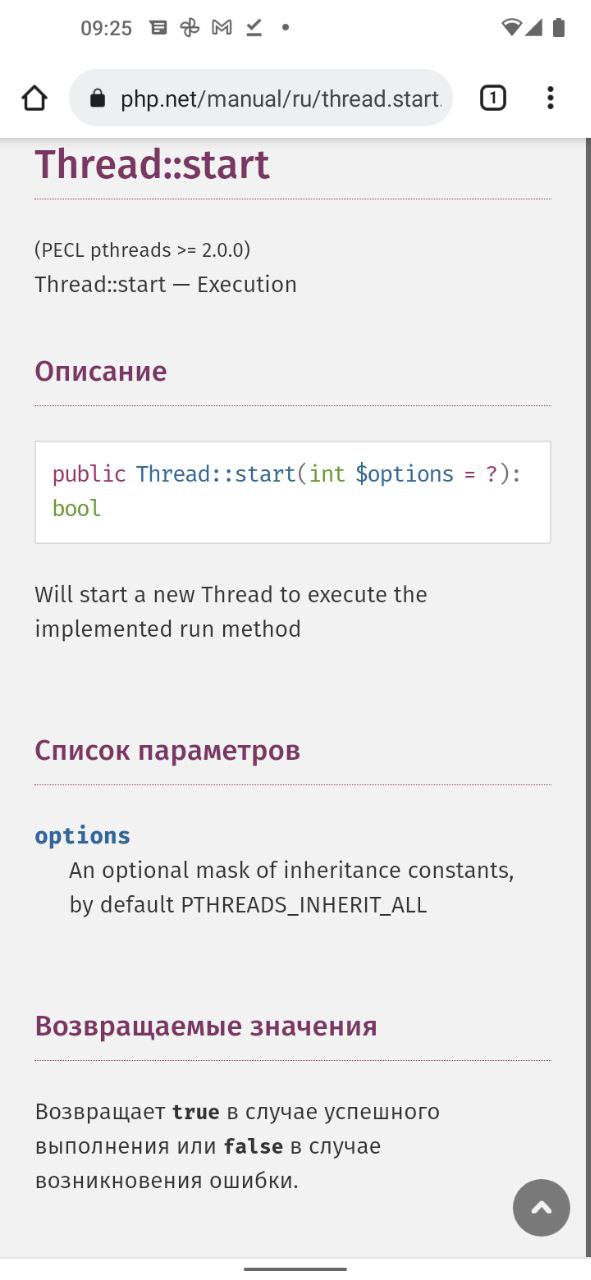

А как оно на пыхе может не в один поток работать?

Andrey

Andrey

Ну это вроде как не из коробки и не на всяком хостинге заведётся... А так то конечно можно было бы как и многопоточность на CURL

atcq (Алексей)

atcq (Алексей)

Я кстати ещё ниразу не встречал "многопоточного дом-краулера" на пыхе

обычно проще запустить несколько обработчиков очереди

Andrey

Andrey

обычно проще запустить несколько обработчиков очереди

Ну это понятно, я собственно так и делал)

Vlad

Vlad

Добрый день, кто юзает спецификации\критерии для получения данных из репозитория. Покажите какой у вас интерфейс спеки\критерия.

Alexander

Alexander

Симфони секьюрити держит пользователя в сессии, и при рефреше (на каждый запрос) дергает его из базы для проверки. Если держать сессии и remeber_me в базе, получается запрос сессии, из сессии достаем юзера и еще раз идем в базу за юзером. А при первом входе еще и remeber_me из базы получается и там тоже рефрешится юзер.

Втф? Как это правильно организовать все?

Иван

Иван

Vlad

Vlad