Алексей

Алексей

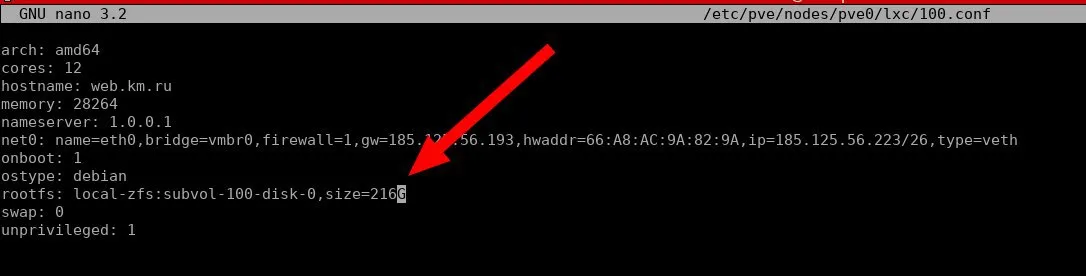

я мигрировал в пул меньшего размера, и у меня в контейнере файловая система уменьшилась, но при этом там так и написано что 1Тб, ну в проксмоксе. А я хочу увеличить теперьместо, а он считает увеличение от 1073Гб и выдаёт ошибку

открой файл конфига виртуальной машины и вбей столько сколько надо

Владимир

Владимир

rootfs:subvol это filesystem. Размер можно через zfs set refquota установить

а как в проксмоксе подправить чтобы он там верное значение показывал?

Ivan

Ivan

Добрый день. Подскажите какие диски взять SATA 2.5 HDD объемом 2 Tb. Что-то не могу подобрать.

добрый день. в какой-то конкретный сервер, хп, например ?

Владимир

Владимир

Добрый день. Подскажите какие диски взять SATA 2.5 HDD объемом 2 Tb. Что-то не могу подобрать.

та они все ноутбучные же)), бери лучше 3,5 там хоть есть из чего выбрать).

Владимир

Владимир

Я ноутбучные беру разве что для тех случаев когда мне они нужны чисто как хранилка к которой я очень редко обращаюсь

Олег

Олег

мне страшно))

подсквжите что произойдет с zfs если отпадет 80% дисков

есть желание к полке добавить полку и боюсь не потеряю ли все если одна полка на часок отпадет

Олег

Олег

а не лучше ли для zfs отключать кэши дисков ?

так понял да лучше и еще 10к технологий, поэтому я пришел к freenas где все должно быть продумано годами за нас

ivdok

ivdok

а не лучше ли для zfs отключать кэши дисков ?

А как ты это сделаешь? Соберёшь UART-шнурок и полезешь в контроллер диска?

Ivan

Ivan

Ему пофиг будет

хз. встречал диски где по дефолту выключено. где нет - выключение давало эффект.

Vladislav

Vladislav

типа "если данное устройство - не партиция, а полный диск - включить кеш"

это плохие настройки, ибо на дисках бывает кривая разметка и в ZFS добавляется партиция, а не сам диск

TokaToka

TokaToka

Друзья, а подскажите пионеру - чем больше vdev в пуле, тем выше скорость чтения/записи? Или я документацию вверх ногами читаю? Диски под данные одинаковые 45*2 тб hdd (7200, consumer graded), под кэш 2*1тб ссд и зил 256гб ссд. Собираюсь работать с большими файлами (20гб и больше) по смб (без вариантов :( ), recordsize поставил 1m. Это не проблема, просто вопрос по архитектуре, поэтому тэгов не ставил, но если что - свистните, исправлюсь :)

Vladislav

Vladislav

Друзья, а подскажите пионеру - чем больше vdev в пуле, тем выше скорость чтения/записи? Или я документацию вверх ногами читаю? Диски под данные одинаковые 45*2 тб hdd (7200, consumer graded), под кэш 2*1тб ссд и зил 256гб ссд. Собираюсь работать с большими файлами (20гб и больше) по смб (без вариантов :( ), recordsize поставил 1m. Это не проблема, просто вопрос по архитектуре, поэтому тэгов не ставил, но если что - свистните, исправлюсь :)

нет.

Я сейчас поищу табличку тестирования

https://wintelguy.com/raidperf.pl

https://jro.io/nas/#overhead

TokaToka

TokaToka

TokaToka

TokaToka

У меня FreeBSD, там в основном буффера и tcp

Кручу фринас, в штатных настройках как файлопомойка на 1вдев/пул на 12 банок себя оправдал более чем, очень понравился. Но вот вещи посерьёзнее, с потоковым чтением/записью и 40гб линком однозначно нуждается в правильной архитектуре и тюнинге.

Олег

Олег

George

George

Друзья, а подскажите пионеру - чем больше vdev в пуле, тем выше скорость чтения/записи? Или я документацию вверх ногами читаю? Диски под данные одинаковые 45*2 тб hdd (7200, consumer graded), под кэш 2*1тб ссд и зил 256гб ссд. Собираюсь работать с большими файлами (20гб и больше) по смб (без вариантов :( ), recordsize поставил 1m. Это не проблема, просто вопрос по архитектуре, поэтому тэгов не ставил, но если что - свистните, исправлюсь :)

Не совсем линейно, но очень грубо - да, если у вас много независимых потоков. Запись скейлится в целом, чтение - примерно тоже, но есть вероятность что нужны будут блоки с одного вдева.

В какой-то момент, конечно же, упрётесть в несовершенство кода в виде нагрузки на цпу и в скорость озу. Arc на разной нагрузке у меня выдавал 9-13гбайт/сек чтения.

George

George

нет.

Я сейчас поищу табличку тестирования

https://wintelguy.com/raidperf.pl

https://jro.io/nas/#overhead

Почему нет, вопрос же про вдевы. Твоя первая ссылка вообще врёт что +1 вдев линейно иопсов прибавляет)

George

George

Друзья, а подскажите пионеру - чем больше vdev в пуле, тем выше скорость чтения/записи? Или я документацию вверх ногами читаю? Диски под данные одинаковые 45*2 тб hdd (7200, consumer graded), под кэш 2*1тб ссд и зил 256гб ссд. Собираюсь работать с большими файлами (20гб и больше) по смб (без вариантов :( ), recordsize поставил 1m. Это не проблема, просто вопрос по архитектуре, поэтому тэгов не ставил, но если что - свистните, исправлюсь :)

А что под "кешем" имеется в виду? L2arc? На большом пуле имеет смысл скорее special vdev сделать

TokaToka

TokaToka

А что под "кешем" имеется в виду? L2arc? На большом пуле имеет смысл скорее special vdev сделать

Да, l2arc. Т.е. 1 vdev на данные, 1vdev под l2arc? По-моему фринас так и предлагает, по-крайней мере zpool status видит их как отдельный вдев. Или я не так понял? С озу проблем нет, сейчас 256гб, но легко можем поднять.

TokaToka

TokaToka

Не совсем линейно, но очень грубо - да, если у вас много независимых потоков. Запись скейлится в целом, чтение - примерно тоже, но есть вероятность что нужны будут блоки с одного вдева.

В какой-то момент, конечно же, упрётесть в несовершенство кода в виде нагрузки на цпу и в скорость озу. Arc на разной нагрузке у меня выдавал 9-13гбайт/сек чтения.

Если по профилю нагрузки - работа с тяжёлым видео, интересует больше скорость чтения в несколько потоков, чем запись. Оно же по vdev по-очереди ходит, верно мыслю?

Dmitry

Dmitry

А что под "кешем" имеется в виду? L2arc? На большом пуле имеет смысл скорее special vdev сделать

извините, что влезаю, а что такое special vdev?

Vladislav

Vladislav

Почему нет, вопрос же про вдевы. Твоя первая ссылка вообще врёт что +1 вдев линейно иопсов прибавляет)

Я калькулятор не писал, если считаете, что там есть ошибки - напишите разработчику.

George

George

George

George

Если по профилю нагрузки - работа с тяжёлым видео, интересует больше скорость чтения в несколько потоков, чем запись. Оно же по vdev по-очереди ходит, верно мыслю?

Примерно, ага, каждый блок на 1 вдев, т.е. При recordsize=1m каждый 1м блок будет на 1ом вдеве лежать рандомно

George

George

извините, что влезаю, а что такое special vdev?

https://openzfs.github.io/openzfs-docs/man/8/zpoolconcepts.8.html?highlight=special#Special_Allocation_Class

George

George

Я калькулятор не писал, если считаете, что там есть ошибки - напишите разработчику.

Ну я не понял почему ты нет ответил) без претензий

Dmitry

Dmitry

Vladislav

Vladislav

Ага, через годик до стейбла бзд довезут наверное

Пусть сначала в основной ветке zfs закроют треть из 1100 ишью

George

George

Пусть сначала в основной ветке zfs закроют треть из 1100 ишью

При чём тут это?) в openzfs 2.0 просто тащат на фрибсд код из zfsonlinux который стал openzfs.

Там про special vdev 1 чтоли ишью свежая и то не воспроизводима пока нормально

Так то открытая ишью != критичный баг, куча про доку, фич реквестов, не актуального, что надо давно закрыть. Велком желающие поучаствовать в раскопках :)

Vladislav

Vladislav

не спасибо, я только буду тестировать FreeBSD 12-STABLE с ZFS и только в этом контексте буду репортить проблемы с ZFS.

TokaToka

TokaToka

Примерно, ага, каждый блок на 1 вдев, т.е. При recordsize=1m каждый 1м блок будет на 1ом вдеве лежать рандомно

Спасибо, так и представлял это. Т.е., например, если я сделаю 9 vdev raidz2 по 5 дисков, это большую часть времени (за исключением ситуаций попадания нужных блоков в 1 vdev) будет быстрее, чем 1 большой vdev на 45? И насколько корректно делать raidz2 из 5 дисков? (с одной стороны у меня прояснилось, с другой запуталось, не ругайте сильно нуба))

George

George

Спасибо, так и представлял это. Т.е., например, если я сделаю 9 vdev raidz2 по 5 дисков, это большую часть времени (за исключением ситуаций попадания нужных блоков в 1 vdev) будет быстрее, чем 1 большой vdev на 45? И насколько корректно делать raidz2 из 5 дисков? (с одной стороны у меня прояснилось, с другой запуталось, не ругайте сильно нуба))

Всё верно, 1 raidz = иопсы одного самого медленного диска в нём.

Raidz2 из пяти дисков - почему бы и нет. Если вам хватит перформанса. Можно конечно просто mirror ов налепить, лучше по иопсам, но больше места сожрёт.

Или 5 raidz2 по 7 дисков можно, меньше иопс даст но больше места.

Вообще ещё spare по хорошему иметь один хотя бы

Олег

Олег

TokaToka

TokaToka

А, точно, спасибо за напоминание про спейры, совсем голова с недосыпа дырявая. Ок, пересчитаю диски и влевы, через сутки-двое соберу и потестирую, напишу, что получилось. Всем большое спасибо за участие! Вы лучшие)

Сергей

Сергей

Fedor

Fedor