Д

Д

Есть такой параметр в описании "Возможность включения SSD-cache, без покупки доп. лицензий" хотя пока не понял что это.

Fedor

Fedor

Зфс предполагает работу на строго локальных дисках, даже сас экспандеры не рекомендуются. Будет медленнее.

Ilia

Ilia

это если скорость "выбрать ленту+вставить ленту" устроит

диск же мгновенно доступ к данным дает

Vladislav

Vladislav

Диски более 10ТБ пора называть инфарктными.

Ибо после их смерти данные почти невозможно восстановить.

Anonymous

Anonymous

у меня хорошо жмутся СУБД и некоторые полупустые ВМ. Фото и видео намного хуже

Фото и видео и не должны сжиматься вообще)

Anonymous

Anonymous

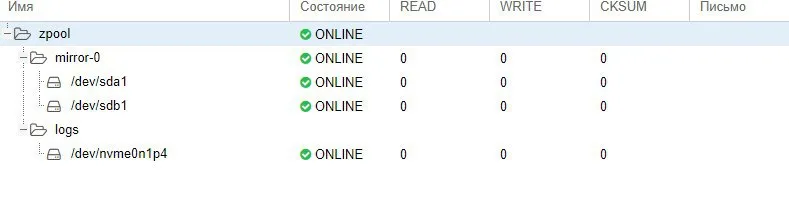

вот кстати думаю а для полки есть смысл ssd кеш делать?

Чето не заметил бонусов на пуле в 40гб кеш был 1гб всего (сам ссд 120гб пустой). Странно както

Д

Д

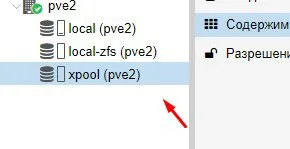

Добрый день, а возможно к существующему пулу, из 1ТБ в зеркале, добавить еще одно такое же зеркало?

Vladislav

Vladislav

да, можно, но если вы захочете равномерно распределить данные между всеми устройствами, то придется сделать финт ушами.

Vladislav

Vladislav

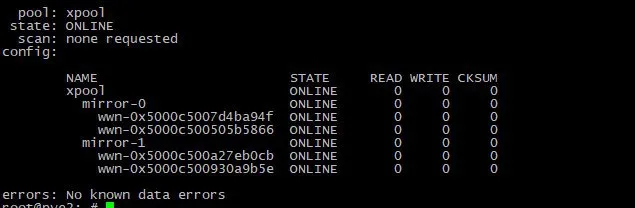

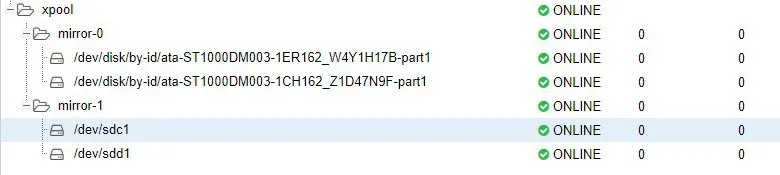

ну сами посмотрите, что вы добавили.

Если диски вдруг сменят нумерацию - пул может развалиться

Vladislav

Vladislav

Например

zpool detach rpool sdg

zpool attach rpool sdh /dev/disk/by-id/wwn-0x5000cca0252faee4

George

George

ну сами посмотрите, что вы добавили.

Если диски вдруг сменят нумерацию - пул может развалиться

Не развалится, zfs'у пофиг на имя и порядок, он на содержимое смотрит

Alexander

Alexander

Хецнер клауд волюмес это виртуальные диски?

я так понимаю, это вот это https://docs.ceph.com/docs/jewel/rbd/rados-rbd-cmds/#resizing-a-block-device-image (блочные устройства Ceph, каждый volume физически находится на 3 серверах, диски SSD)

Alexander

Alexander

у них можно подключить к 1 VPS несколько volume'ов, каждый из которых может быть от 10 ГБ до 10ТБ, можно ресайзить

Fedor

Fedor

Почему спрашиваю - зфс проектировалась под поведение обычных жёстких дисков, учитывая то, что если диск ответил Ок при записи - данные точно сохранены.

Fedor

Fedor

Поведение виртуальных дисков, в которых вложено некоторое количество уровней абстракции, может отличаться от эталонного, скажем так. Даже на стороне гипервизора.

Fedor

Fedor

При каком-то из сбоев на пути следования может произойти порча данных - то, что зфс считала записанным, пропадёт и возникнет неопределенное состояние.

Alexander

Alexander

я немного поискал в истории чата и не понял этот момент, без ECC-памяти хранилище с ZFS будет работать менее надёжно, чем XFS?

Fedor

Fedor

а если бы диски были локальными, но память не была бы ECC?

Повреждение битов в памяти перед записью заблокирует больший объём информации в случае с зфс, чем с другими фс

Alexander

Alexander

ага, то есть какие-то скрипты/программы, которые попытаются прочитать эти участки, не смогут это сделать без ручного вмешательства потому что ZFS явно скажет, что тут всё сломано?

George

George

Если важна надежность, я бы не стал так экспериментировать без локальных хранилищ.

а потом человек приходит в клауд флуд и говорит что "а в чатике зфс сказали что менее надёжно")))

Сергей

Сергей

Алексей

Алексей

Григорий

Григорий