Не рекомендуются самим вендором, снижают производительность

Кем именно? И откуда деградация? Серьезно :)))

Fedor

Fedor

Страшно терять данные, а деградировать на пару процентов - нормально

При соблюдении правил потери данных не будет. Зфс не имеет известных проблем.

Mikhail

Mikhail

Да, читайте официальные гайды

дай ссылку. Официально ZFS не, есть ZoL, есть ZoF и есть коммунити размазанное между ними.

Fedor

Fedor

Вот официальный зфс говорит, что надо. Дериватив в виде развития в пределах иллюмоса- тоже. Зол - не знаю, но он должен быть подчинен примерно тем же правилам

Mikhail

Mikhail

ZFS will also create a GPT partition table own partitions when given a whole disk under illumos on x86/amd64 and on Linux. This is mainly to make booting through UEFI possible because UEFI requires a small FAT partition to be able to boot the system. The ZFS driver will be able to tell the difference between whether the pool had been given the entire disk or not via the whole_disk field in the label.

Mikhail

Mikhail

Whole disks should be given to ZFS rather than partitions. - "should be" - никакой деградации производительности во фразе нет ))

Mikhail

Mikhail

возвращая к исходному вопросу про RootOnZFS, RootOnZFS нормально работает при создания пула через партиции и дублировании boot партиции. Без потери производительности и без прочих side эффектов

Fedor

Fedor

Whole disks should be given to ZFS rather than partitions. - "should be" - никакой деградации производительности во фразе нет ))

Смотри. Знаешь, как делают хауту-админы? Берут инструкции и делают без понимания того, что надо и что происходит. Иногда мажут мимо алайна. Иногда мажут в самих вм мимо блоксайза звола, но уже нечасто - сами ОС стали умнее и делают обязательный оффсет. В применении именно к дискам партиции нежелательны по причине усложнённого рекавери при сбоях.

Fedor

Fedor

Mikhail

Mikhail

рут всего лишь система, а rootonzfs - это уже больше чем система, к примеру boot environment-ы. партиции восстановить не сложно, если их бекапить ;) всего килобайт информации)))

Fedor

Fedor

Читайте администрейшн гайды, в общем. Там ко всем рекомендациям даны исчерпывающие обоснования.

Mikhail

Mikhail

Читайте администрейшн гайды, в общем. Там ко всем рекомендациям даны исчерпывающие обоснования.

странная у вас реакция конечно. особенно если читали и гайды и код... мда ))) прошу относить без обид, но никто не застрахован от ошибок и лишь в конструктивных обсуждениях может выявить верные факты и теории. для этого чат то и существует, не так ли? та же установка FreeBSD как RootOnZFS успешно проставляет алайны и прочие вещи сама. Остаётся только настроить бекапы через zrepl + gpart backup.

Fedor

Fedor

В чатике я рад помочь, подсказать, затраблшутить, но переубеждать в игнорировании рекомендаций, основанных на математической модели самой ФС с припиской «и так работает» мне не слишком интересно.

Fedor

Fedor

В отношении ос и алайнов- сами ос стали немного умнее и заранее делают офсет для фс, который уложится практически в любой из существующих блоков. Толи мегабайт, толи 4

Fedor

Fedor

Со временем я пришёл к идеологии, что и системы, и сервера - расходный материал в пользу сохранения невосстановимых данных и работоспособности сервисов. Управлять этим сразу становится проще.

Fedor

Fedor

странная у вас реакция конечно. особенно если читали и гайды и код... мда ))) прошу относить без обид, но никто не застрахован от ошибок и лишь в конструктивных обсуждениях может выявить верные факты и теории. для этого чат то и существует, не так ли? та же установка FreeBSD как RootOnZFS успешно проставляет алайны и прочие вещи сама. Остаётся только настроить бекапы через zrepl + gpart backup.

Я тут подумал. Может быть так, что я предпочитаю рекомендации для того, чтобы снять с себя лишнюю головную боль в обслуживании этого балагана. Чем больше ключевых рекомендаций соблюдено, тем меньше мне придётся возвращаться к этой системе, потому, что она просто будет работать, и работать предсказуемо. Операции по траблшутингу, количество действий по восстановлению в случае проблем, также будет минимизировано.

Andrey

Andrey

Заработает, да. Но в случае ошибок зфс это прочувствует далеко не сразу. И вероятность получить бад чексум в этом случае несколько выше.

Как получит, так исправит. Это же одна из тех фич , за которые мы её и любим. А если исправить не может - значит диск менять хоть так, хоть иначе.

Fedor

Fedor

Как получит, так исправит. Это же одна из тех фич , за которые мы её и любим. А если исправить не может - значит диск менять хоть так, хоть иначе.

Ошибка, хоть и штатная ситуация - нежелательна, увы.

Andrey

Andrey

Ошибка, хоть и штатная ситуация - нежелательна, увы.

Это ваш перфекционизм говорит? Или вы живёте в идеальном мире? Выход из строя диска в рэйд массиве ситуация нежелательная, увы, но штатная.

Andrey

Andrey

Мне кажется , я говорю полуполный, а ты - полупустой. ☺️ А так да, говорим об одном и том же.

Fedor

Fedor

Добро пожаловать в сообщество ZFS.

Прошу свои сообщения помечать для упрощения поиска тэгами: #проблема #решение #faq #man #doc и подобными. Тэгируя вы помогаете собрать базу знаний.

Правила чата:

1) У вас вопрос и/или проблема? Уважайте время людей, пишите больше деталей.

2) Запрещены:

2.1) Флуд не по теме

2.2) Срач

2.3) Оскорбления

2.4 ) Расизм / разжигание межнациональной розни / фашизм

2.5) Наркотики

2.6) Экстремизм ( согласно УК РФ )

2.7) Варез

Отказ от ответсвенности: публикация ссылок на варез и его использование на свой страх и риск. Администрация чата не несёт ответственности за это.

Кара за нарушения:

2.1 + 2.2 + 2.3: только чтение --> бан --> перманент бан

2.4 + 2.5 + 2.6: бан --> перманент бан

Дружественный чат Proxmox: @ru_proxmox

---

Администатор: @neurox

---

Moderators: @iacsvrn

---

Konstantin

Konstantin

http://www.zfsbuild.com/2010/05/26/zfs-raid-levels/

Посмотри тут

В частности

Mirrored Vdev’s (RAID1)

This is akin to RAID1. If you mirror a pair of Vdev’s (each Vdev is usually a single hard drive) it is just like RAID1, except you get the added bonus of automatic checksumming. This prevents silent data corruption that is usually undetectable by most hardware RAID cards. Another bonus of mirrored Vdev’s in ZFS is that you can use multiple mirrors. If we wanted to mirror all 20 drives on our ZFS system, we could. We would waste an inordinate amount of space, but we could sustain 19 drive failures with no loss of data. How To Create Mirrored Vdev Zpool

Konstantin

Konstantin

Mirrored Vdev’s are equivalent to a RAID1 array, with the added bonus of checksum data to prevent silent data corruption. The performance of a Mirrored Vdev Zpool will be very similar to a RAID1 array.

Александр🇷🇺

Александр🇷🇺

Fedor

Fedor

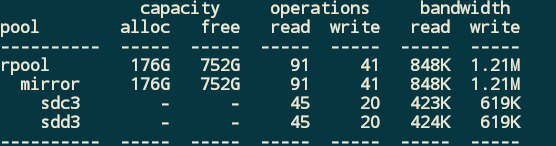

Я с телефона. zpool iostat покажет конфигурацию. Выложишь вывод сюда - скажу, что из чего у тебя сделано.

LeiDruid

LeiDruid

mirror 116G

ata-Samsung_SSD_850_PRO_1TB_S2BBNWAJ203038Y -

ata-Samsung_SSD_850_PRO_1TB_S2BBNWAJ103167Z -

mirror 116G

ata-Samsung_SSD_850_PRO_1TB_S2BBNWAJ204415X -

ata-Samsung_SSD_850_PRO_1TB_S2BBNWAJ203034L -

mirror 116G

ata-Samsung_SSD_850_PRO_1TB_S2BBNWAJ204412N -

ata-Samsung_SSD_850_PRO_1TB_S2BBNWAJ204416J -

вроде ровненько

Mikhail

Mikhail

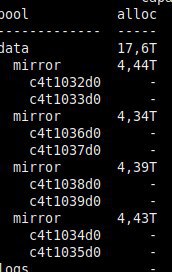

Аллок

mizhka@summerhouse:~ % zpool iostat -v

capacity operations bandwidth

pool alloc free read write read write

-------------- ----- ----- ----- ----- ----- -----

zvol 2.74T 2.70T 16 113 1.17M 8.15M

raidz2 2.74T 2.70T 16 113 1.17M 8.15M

gpt/zvol00 - - 8 91 225K 2.09M

gpt/zvol01 - - 7 88 180K 2.09M

gpt/zvol02 - - 8 90 196K 2.08M

gpt/zvol03 - - 8 87 222K 2.09M

gpt/zvol04 - - 7 84 180K 2.09M

gpt/zvol05 - - 8 86 199K 2.08M

-------------- ----- ----- ----- ----- ----- -----

хм... так он не показывает по vdev-ам

Mikhail

Mikhail

то есть ты не про диски под vdev, а про страйп поверх vdev в zpool? сорри, неправильно прочитал вопрос.

Mikhail

Mikhail

Mikhail

Mikhail

ощущение, что там выбор вдева для записи по хешу производится :)

либо же там как-то за объекты завязано все