𝕋𝕒𝕘𝕚𝕣𝔾𝕚

𝕋𝕒𝕘𝕚𝕣𝔾𝕚

Gustavo Imputsa

Gustavo Imputsa

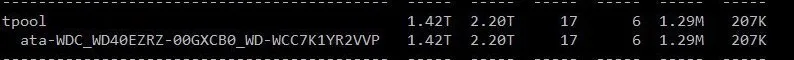

диски dc500r, пулл miror striped vdevs, занято меньше 50%, хотя вчера пока тестировал там и 75% было, и хуже особо не было

Таргет через веб консоль создавал, дефолтный наверное

по top интеррупт в районе 1-2 процентов (вы вед про это говорили?), из других нагрузок только одна вм на 512 мб (прокс qdevice), как

доставил ссд что бы 30% было занято, про таргет так и не понял, там же один только который ядерный?

за вчера еще обновил фринас и все прошивки, продолжаю гонять

Сергей

Сергей

по top интеррупт в районе 1-2 процентов (вы вед про это говорили?), из других нагрузок только одна вм на 512 мб (прокс qdevice), как

доставил ссд что бы 30% было занято, про таргет так и не понял, там же один только который ядерный?

за вчера еще обновил фринас и все прошивки, продолжаю гонять

правильно ли я понимаю что пул собран на freenas, а прокс только принимает по iscsi с фринаса? и скорость работы с данным пулом не получилось сделать более 200мбит/с?

Сергей

Сергей

ну по iperf 10 гбит проходит

так это сетка способна прокачать. А способен ли фринас выдать такую скорость?

Сергей

Сергей

сам фринас может. могут ли диски.

я это и имел ввиду. может просто пул медленно работает, или что-то на фринасе неправильно настроено

Gustavo Imputsa

Gustavo Imputsa

fio --randrepeat=1 --direct=1 --gtod_reduce=1 --name=test --filename=test --bs=4k --iodepth=64 --size=4G --readwrite=write --rwmixread=75

на freenas (пулл тот же но запускаю из датасета)

test: (g=0): rw=write, bs=(R) 4096B-4096B, (W) 4096B-4096B, (T) 4096B-4096B, ioengine=psync, iodepth=64

fio-3.16

Starting 1 process

Jobs: 1 (f=1): [W(1)][100.0%][w=340MiB/s][w=87.1k IOPS][eta 00m:00s]

test: (groupid=0, jobs=1): err= 0: pid=87485: Sun Mar 15 10:40:32 2020

write: IOPS=82.8k, BW=323MiB/s (339MB/s)(4096MiB/12667msec)

bw ( KiB/s): min=300838, max=352654, per=98.96%, avg=327662.88, stdev=15447.83, samples=25

iops : min=75209, max=88163, avg=81915.24, stdev=3861.94, samples=25

cpu : usr=6.66%, sys=92.19%, ctx=7058, majf=0, minf=0

IO depths : 1=100.0%, 2=0.0%, 4=0.0%, 8=0.0%, 16=0.0%, 32=0.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

issued rwts: total=0,1048576,0,0 short=0,0,0,0 dropped=0,0,0,0

latency : target=0, window=0, percentile=100.00%, depth=64

Run status group 0 (all jobs):

WRITE: bw=323MiB/s (339MB/s), 323MiB/s-323MiB/s (339MB/s-339MB/s), io=4096MiB (4295MB), run=12667-12667msec

из виртуалки proxmox

test: (g=0): rw=write, bs=(R) 4096B-4096B, (W) 4096B-4096B, (T) 4096B-4096B, ioengine=psync, iodepth=64

fio-3.1

Starting 1 process

Jobs: 1 (f=1): [W(1)][100.0%][r=0KiB/s,w=18.4MiB/s][r=0,w=4714 IOPS][eta 00m:00s]

test: (groupid=0, jobs=1): err= 0: pid=2051: Sun Mar 15 17:44:09 2020

write: IOPS=4881, BW=19.1MiB/s (19.0MB/s)(4096MiB/214811msec)

bw ( KiB/s): min=14000, max=22480, per=100.00%, avg=19524.10, stdev=1571.55, samples=429

iops : min= 3500, max= 5620, avg=4881.00, stdev=392.90, samples=429

cpu : usr=2.36%, sys=12.31%, ctx=1048684, majf=0, minf=9

IO depths : 1=100.0%, 2=0.0%, 4=0.0%, 8=0.0%, 16=0.0%, 32=0.0%, >=64=0.0%

submit : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

complete : 0=0.0%, 4=100.0%, 8=0.0%, 16=0.0%, 32=0.0%, 64=0.0%, >=64=0.0%

issued rwt: total=0,1048576,0, short=0,0,0, dropped=0,0,0

latency : target=0, window=0, percentile=100.00%, depth=64

Run status group 0 (all jobs):

WRITE: bw=19.1MiB/s (19.0MB/s), 19.1MiB/s-19.1MiB/s (19.0MB/s-19.0MB/s), io=4096MiB (4295MB), run=214811-214811msec

Disk stats (read/write):

sdb: ios=0/1047876, merge=0/42, ticks=0/190116, in_queue=2484, util=1.16%

Сергей

Сергей

Сергей

Сергей

Сергей

Сергей

Сергей

Сергей

Сергей

Сергей

только нужно создать блочное устройство на пуле и прописать путь к нему (filename=) в .fio (ДАННЫЕ БУДУТ ЗАТЁРТЫ на нём!), ну а на хосте/ВМ соответственно указать другие свои соответствующие имена

Gustavo Imputsa

Gustavo Imputsa

вот https://pastebin.com/q7KixRu0

только это ioengine=psync, а то не получилось у меня поставить libaio

Сергей

Сергей

может ли быть из-за размера блока такое? на порядки разница…

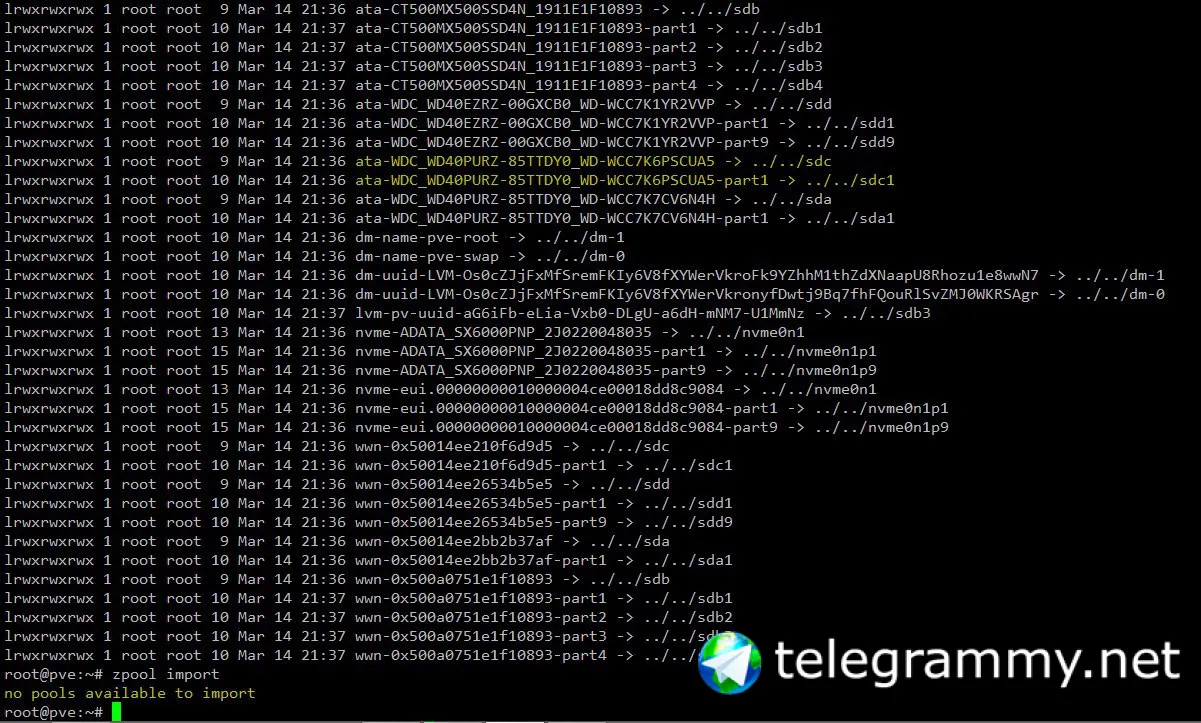

вы про какой размер блока? у вас на фринасе вольюмы как созданы? zfs list выведите

zfs list -t all -o type,name,used,avail,compressratio,logbias,sync,volblocksize

Сергей

Сергей

вот https://pastebin.com/q7KixRu0

только это ioengine=psync, а то не получилось у меня поставить libaio

и где результаты ещё одного слоя между ВМ и фринасом? на хосте(проксмоксе)

Gustavo Imputsa

Gustavo Imputsa

TYPE NAME USED AVAIL RATIO LOGBIAS SYNC VOLBLOCK

filesystem pool_pve_fast 2.80T 2.24T 1.03x latency standard -

volume pool_pve_fast/vm-113-disk-2 8.04G 2.24T 1.00x latency standard 4K

Gustavo Imputsa

Gustavo Imputsa

Прогнал те же тесты с виртуалки на на другой хост который по витухе и с того хоста в тот же lun.

С десктопа на freenas иопсов столько же, а вот с виртуалки на десктоп иопсов больше получается.

Погоняю завтра ещё, примерно понял куда смотреть надо

LeiDruid

LeiDruid

А почему не

FLUSH TABLES WITH READ LOCK;

Специально же для этого, так сказать)

Ну потому что это лок. Сама команда станет в очередь, а там может быть какая-то непредсказуемо долгая транзакция.

Сергей

Сергей

Прогнал те же тесты с виртуалки на на другой хост который по витухе и с того хоста в тот же lun.

С десктопа на freenas иопсов столько же, а вот с виртуалки на десктоп иопсов больше получается.

Погоняю завтра ещё, примерно понял куда смотреть надо

попробуйте поднять хранилище не на freenas, а например на базе http://esos-project.com/

Autumn

Autumn

FreeNAS капец медленный. Ну или я не смог его приготовить, но простая замена два года назад freenas на ubuntu 18.04 сразу дала на том же железе двукратный прирост по производительности ФС. Да там было без наворотов, просто дисковый массив z2 из 6 sata 7k2 дисков. Но это была тупая бэкапилка под прокс, в которой мы zfs pool отдали по nfs4 как сторадж для бэкапов. L2arc не строили, оперативы было 16ГБ, zil утачили на 128 гиговую ссд. И простая замена ос решила все. А так да, вебморда у фринаса прикольная.

Сергей

Сергей

У нас его вроде бы поставили за http api что бы бесплатные бекапа из прокса были

посмотрите в сторону esos. Это программная хранилка на основе linux. умеет также отдавать по iscsi zfs

Gustavo Imputsa

Gustavo Imputsa

А может быть проблема на чипсете или в прерываниях где то? Прерывания по инструкции mellanox делал

Если за сегодня не разберусь, esos чекну, не хочется прям бежать менять, много скриптов автоматизации на фринас завязанно.

Спасибо вам огромное за помощь!

Autumn

Autumn

Короче поставлю сетевуху Интел и посмотрю что будет

у нас изначально было на интелах - не помогло ...

Gustavo Imputsa

Gustavo Imputsa

А если просто поставить убуту (там же есть zfs-on-linux) и все тоже самое там поднять, есть подводные? Ну версию пулла и шифрование проверить очевидно. А именно по производительности у ZoL все хорошо, никто не сталкивался?

George

George

А если просто поставить убуту (там же есть zfs-on-linux) и все тоже самое там поднять, есть подводные? Ну версию пулла и шифрование проверить очевидно. А именно по производительности у ZoL все хорошо, никто не сталкивался?

явных бед по перформансу у zol vs freebsd zfs нет точно

Сергей

Сергей

А если просто поставить убуту (там же есть zfs-on-linux) и все тоже самое там поднять, есть подводные? Ну версию пулла и шифрование проверить очевидно. А именно по производительности у ZoL все хорошо, никто не сталкивался?

на убунте target какой будете ставить? От этого тоже будет зависеть производительность iscsi. И на esos -тоже кстати ZoL

Gustavo Imputsa

Gustavo Imputsa

А если просто поставить убуту (там же есть zfs-on-linux) и все тоже самое там поднять, есть подводные? Ну версию пулла и шифрование проверить очевидно. А именно по производительности у ZoL все хорошо, никто не сталкивался?

Короче что бы не скролил никто в поиске #решение

Потестил, без свитча стало получше, судя по всему это тупо latency. Убунта и смена таргетов не сильно помогала.

Сергей

Сергей

Короче что бы не скролил никто в поиске #решение

Потестил, без свитча стало получше, судя по всему это тупо latency. Убунта и смена таргетов не сильно помогала.

так у вас не только латенси, у вас ведь и пропускная падает. Вы попробовали esos? там target в ядре (SCST)

Vladislav

Vladislav

Хочется удалить некоторые снапшоты, но оказываются там есть зависимости:

# zfs destroy tank/video@2020-03-04_00.01.00--1w

cannot destroy 'tank/video@2020-03-04_00.01.00--1w': snapshot has dependent clones

use '-R' to destroy the following datasets:

tank/video/serials@2020-03-15_18.01.00--1w

tank/video/serials@2020-03-19_12.01.00--1w

...

Vladislav

Vladislav

NAME USED AVAIL REFER MOUNTPOINT

tank/video 10,6T 24,2T 112K /tank/video

tank/video@2020-03-04_00.01.00--1w 10,3T - 10,3T -

tank/video@2020-03-14_18.01.00--1w 0 - 112K -

...

George

George

Grzegorz

Grzegorz

Хочется удалить некоторые снапшоты, но оказываются там есть зависимости:

# zfs destroy tank/video@2020-03-04_00.01.00--1w

cannot destroy 'tank/video@2020-03-04_00.01.00--1w': snapshot has dependent clones

use '-R' to destroy the following datasets:

tank/video/serials@2020-03-15_18.01.00--1w

tank/video/serials@2020-03-19_12.01.00--1w

...

Снимки как слои накладываются , если удалять нижний слой - верхние так же необходимо удалять. Тем более в выводе подсказка как это сделать .

Vladislav

Vladislav

Значит, пичально, оставляю как есть.

Как всегда, у новых технологий есть ряд нетривиальных ситуаций

George

George

Значит, пичально, оставляю как есть.

Как всегда, у новых технологий есть ряд нетривиальных ситуаций

Ау, я выше вам ответил что делать с клонами)

Vladislav

Vladislav

по там еще на этом разделе снимок с syncoid_ для синхронизации, так что неизвестно, удасться ли обмануть

Vladislav

Vladislav

Вот сейчас:

# zfs list -r tank/video

NAME USED AVAIL REFER MOUNTPOINT

tank/video 10,7T 24,2T 112K /tank/video

tank/video/serial_fragments 23,1G 24,2T 23,0G /tank/video/serial_fragments

tank/video/serials 233G 24,2T 10,6T /tank/video/serials

tank/video/video_parts 65,7G 24,2T 65,5G /tank/video/video_partsЕсли я сделаю:

zfs promote tank/videoZFS нЕ сбросит снимки tank/video/serials ?

nikolay

nikolay

коллеги, на всякий случай уточню. планирую обновить centos с версии 7.6 до версии 7.7 через yum. Могу ли я просто обновить xfs через репозиторий после обновления системы или мне надо будет удалять старые пакеты и модули и ставить новые из репозитория для 7.7? версия zol 0.7.13, ставил как kABI zfs-kmod

George

George

коллеги, на всякий случай уточню. планирую обновить centos с версии 7.6 до версии 7.7 через yum. Могу ли я просто обновить xfs через репозиторий после обновления системы или мне надо будет удалять старые пакеты и модули и ставить новые из репозитория для 7.7? версия zol 0.7.13, ставил как kABI zfs-kmod

https://github.com/openzfs/zfs/wiki/RHEL-and-CentOS#rhelcentos-7x-kmod-package-upgrade

nikolay

nikolay

https://github.com/openzfs/zfs/wiki/RHEL-and-CentOS#rhelcentos-7x-kmod-package-upgrade

понял, спасибо, других вариантов нет. будем придерживаться официальной документации.

nikolay

nikolay

https://github.com/openzfs/zfs/wiki/RHEL-and-CentOS#rhelcentos-7x-kmod-package-upgrade

делать реинсталл zfs я должен сразу после перезагрузки системы после обновления? или сначала удаляю пакеты zfs, потом обновляю?

George

George

George

George

просто если нет - то система должна по идее загрузиться и без zfs.

Вообще утром инструкцию, которую кидал, мельком глядел - там до ребута обновлялось

Fedor

Fedor