Sergey

Sergey

я ж выше объяснял, что да, можно во всем пройтись и найти, но там в исходниках не создаются эти kstat для снапшотов и написано что вобщем то ничего не мешает их создать, соответственно со снапшотмаи этих файлов может стать тысячи и хз насколько хороши их так активно дергать

Sergey

Sergey

поэтому хотел зайти с другой стороны, если б это было доступно в zfs get all или чем-то подобном)

Sergey

Sergey

ааа, https://github.com/zfsonlinux/zfs/commit/a448a2557ec4938ed6944c7766fe0b8e6e5f6456#diff-0bfd29fd3d339a7728ad9ca731392de0

ага, заметил в 8ке новые файлы и решил разобраться что это, а там такой кладезь)

Sergey

Sergey

ааа, https://github.com/zfsonlinux/zfs/commit/a448a2557ec4938ed6944c7766fe0b8e6e5f6456#diff-0bfd29fd3d339a7728ad9ca731392de0

ну кстати из этой ссылки

ZFS_PROP_OBJSETID, /* not exposed to the user */

наверное отвечает на мой вопрос :D

George

George

Since we are not sure how useful they would be

* though nor how much their memory overhead would matter in

* a filesystem with many snapshots, we skip them for now.

George

George

вот, полезно иногда к общим знаниям воззвать, хотя я вроде и ман просматривал)

я про этот id забыл, как и про патч, и сразу тебя не понял)

Sergey

Sergey

по txg ифа есть, d файле io все по лейтенси и иопсам по пулу есть, и теперь и по датасетам иопсы есть)

Sergey

Sergey

было бы отлично научить проксмокс видеть эти данные

ну вот я хочу это вытащить в тот же заббикс

Sergey

Sergey

было бы отлично научить проксмокс видеть эти данные

кстати может им сообщить, может они и не знают про эту фичу)

Сергей

Сергей

пулл реквет? так в зфс то сделали все что надо для этого)

да. но сейчас zfs iostat не реализован. Я в шутку и предлагаю вам этот механизм вывода статистики реализовать

Sergey

Sergey

нуууу... т.к. я сварщик не настоящий если только в меня потом не будут кидаться камнями за то, что при его вызове будет panic/segfault итд :D

Сергей

Сергей

нуууу... т.к. я сварщик не настоящий если только в меня потом не будут кидаться камнями за то, что при его вызове будет panic/segfault итд :D

ну PR могут и не принять, а идею подхватят). Ведь на самом деле полезно увидеть какой из датасетов нагружен. Можно кстати попробовать и для проксмокса PR/issue сделать на эту тему.

George

George

спросил людей, которые делали этот патч об инструментах, думаю они наверняка этот вопрос уже обдумывали https://github.com/zfsonlinux/zfs/pull/7705#issuecomment-582901326

Fedor

Fedor

я тут думал косметический патч в бинутилс предложить. почитал, как это у них делается.. пока что передумал :D

Sergey

Sergey

спросил людей, которые делали этот патч об инструментах, думаю они наверняка этот вопрос уже обдумывали https://github.com/zfsonlinux/zfs/pull/7705#issuecomment-582901326

о писание оказывается есть, может я неправильно пользуюсь гуглом :D

Sergey

Sergey

вообще я протупил, вместо того что б шариться по исходникам надо было глянуть хистори и увидеть этот начальный коммит

George

George

вообще я протупил, вместо того что б шариться по исходникам надо было глянуть хистори и увидеть этот начальный коммит

ага, в PR обычно куча инфы и контекста)

George

George

я ж говорю сварщик не настоящий) а тупо поиском pr не всегда находится, да

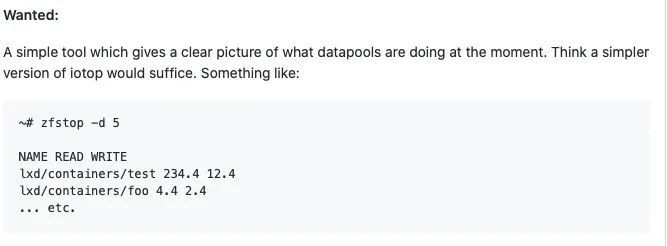

https://github.com/zfsonlinux/zfs/pull/7705#issuecomment-583201281

Sergey

Sergey

Еще большой прорыв был когда в 0.7.х в iostat завезли лейтенси и io size histogram а так же всяческие статистики по очередям и задержкам вплоть до конкретного девайса

George

George

George

George

Ага, я кстати issue по zpool list -v с -o открыл

видел, ты кстати прав был, я внимательнее глянул и у дисков поля то те же выводятся, просто и их фильтровать надо

Gustavo Imputsa

Gustavo Imputsa

всем привет, после ребута не импортируется пулл

root@freenas[~]# zpool import -FX -f

pool: pool1_pve

id: 8799729420786166239

state: FAULTED

status: One or more devices are missing from the system.

action: The pool cannot be imported. Attach the missing

devices and try again.

The pool may be active on another system, but can be imported using

the '-f' flag.

see: http://illumos.org/msg/ZFS-8000-3C

config:

pool1_pve FAULTED corrupted data

raidz2-0 DEGRADED

8893117777881115282 UNAVAIL cannot open

2596649909032266628 UNAVAIL cannot open

gptid/af0340f7-3d4e-11ea-b62c-ac1f6bb5d7c4.eli ONLINE

gptid/b0200be9-3d4e-11ea-b62c-ac1f6bb5d7c4.eli ONLINE

gptid/b138c5fd-3d4e-11ea-b62c-ac1f6bb5d7c4.eli ONLINE

gptid/59001998-42c3-11ea-8b0a-ac1f6bb5d7c4.eli ONLINE

gptid/b37e4c2c-3d4e-11ea-b62c-ac1f6bb5d7c4.eli ONLINE

geli, на тех двух дисказ что UNAVAIL пишет что ключ неверный.

перед ребутом было такое

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/59001998-42c3-11ea-8b0a-ac1f6bb5d7c4.eli[READ(offset=0, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/59001998-42c3-11ea-8b0a-ac1f6bb5d7c4.eli[READ(offset=262144, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/59001998-42c3-11ea-8b0a-ac1f6bb5d7c4.eli[READ(offset=3998638931968, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/59001998-42c3-11ea-8b0a-ac1f6bb5d7c4.eli[READ(offset=3998639194112, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/af0340f7-3d4e-11ea-b62c-ac1f6bb5d7c4.eli[READ(offset=0, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/af0340f7-3d4e-11ea-b62c-ac1f6bb5d7c4.eli[READ(offset=262144, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/af0340f7-3d4e-11ea-b62c-ac1f6bb5d7c4.eli[READ(offset=3998638931968, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/af0340f7-3d4e-11ea-b62c-ac1f6bb5d7c4.eli[READ(offset=3998639194112, length=131072)]

(хз стоит ли на пастебин лить)

мое предположение в том что в READ(offset=0, находился какой то заголовок и он не может из-за него расшифровать

да и по идее потеря двух дисков не должна приводить к потере данных (только потери подтверждения целостонсть, ведь так?)

еще было предположение что UNAVALI не изза двух дисков а из-за потери транзакции или что то типо того, но я так и не разобрался с zdb -ul pool1_pve

пишет cannot open '/dev/rdsk/pool1_pves0': No such file or directory

по факту /dev/rdsk/ не существует

да и вот таким пугает

zpool import -f 8799729420786166239

cannot import 'pool1_pve': I/O error

Destroy and re-create the pool from

a backup source.

можно ли как то заставить geli забить на заголовок или там какие то метаданные которые не только для проверки пароля?

или можно как то согласиться с тем что проверки целостностит больше нет и заменить диски?

или может быть возможно забить последние транзакции?

George

George

всем привет, после ребута не импортируется пулл

root@freenas[~]# zpool import -FX -f

pool: pool1_pve

id: 8799729420786166239

state: FAULTED

status: One or more devices are missing from the system.

action: The pool cannot be imported. Attach the missing

devices and try again.

The pool may be active on another system, but can be imported using

the '-f' flag.

see: http://illumos.org/msg/ZFS-8000-3C

config:

pool1_pve FAULTED corrupted data

raidz2-0 DEGRADED

8893117777881115282 UNAVAIL cannot open

2596649909032266628 UNAVAIL cannot open

gptid/af0340f7-3d4e-11ea-b62c-ac1f6bb5d7c4.eli ONLINE

gptid/b0200be9-3d4e-11ea-b62c-ac1f6bb5d7c4.eli ONLINE

gptid/b138c5fd-3d4e-11ea-b62c-ac1f6bb5d7c4.eli ONLINE

gptid/59001998-42c3-11ea-8b0a-ac1f6bb5d7c4.eli ONLINE

gptid/b37e4c2c-3d4e-11ea-b62c-ac1f6bb5d7c4.eli ONLINE

geli, на тех двух дисказ что UNAVAIL пишет что ключ неверный.

перед ребутом было такое

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/59001998-42c3-11ea-8b0a-ac1f6bb5d7c4.eli[READ(offset=0, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/59001998-42c3-11ea-8b0a-ac1f6bb5d7c4.eli[READ(offset=262144, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/59001998-42c3-11ea-8b0a-ac1f6bb5d7c4.eli[READ(offset=3998638931968, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/59001998-42c3-11ea-8b0a-ac1f6bb5d7c4.eli[READ(offset=3998639194112, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/af0340f7-3d4e-11ea-b62c-ac1f6bb5d7c4.eli[READ(offset=0, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/af0340f7-3d4e-11ea-b62c-ac1f6bb5d7c4.eli[READ(offset=262144, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/af0340f7-3d4e-11ea-b62c-ac1f6bb5d7c4.eli[READ(offset=3998638931968, length=131072)]

Feb 6 15:59:05 freenas GEOM_ELI: g_eli_read_done() failed (error=6) gptid/af0340f7-3d4e-11ea-b62c-ac1f6bb5d7c4.eli[READ(offset=3998639194112, length=131072)]

(хз стоит ли на пастебин лить)

мое предположение в том что в READ(offset=0, находился какой то заголовок и он не может из-за него расшифровать

да и по идее потеря двух дисков не должна приводить к потере данных (только потери подтверждения целостонсть, ведь так?)

еще было предположение что UNAVALI не изза двух дисков а из-за потери транзакции или что то типо того, но я так и не разобрался с zdb -ul pool1_pve

пишет cannot open '/dev/rdsk/pool1_pves0': No such file or directory

по факту /dev/rdsk/ не существует

да и вот таким пугает

zpool import -f 8799729420786166239

cannot import 'pool1_pve': I/O error

Destroy and re-create the pool from

a backup source.

можно ли как то заставить geli забить на заголовок или там какие то метаданные которые не только для проверки пароля?

или можно как то согласиться с тем что проверки целостностит больше нет и заменить диски?

или может быть возможно забить последние транзакции?

Ох, 2 диска за раз, что-то из железа дохнет?

Если данные важны и бекапов нет - нормальной практикой перед пробами импортнуть стоит сделать полные копии дисков dd шкой и на этом играться.

Про geli не подскажу, но я бы сначала попробовал понять что ему не нравится, и уже потом пытаться пул импортнуть.

Сколько дисков изначально в массиве было?

George

George

Сергей

Сергей

ну, так пишите howto как правильно готовить ZFS для Postgres и 1С

в группе PostgreSQL + 1C + Linux, Роман отправлял уже ссылку, продублирую здесь:

https://github.com/rsyuzyov/work-on-linux

начать можно с неё, в самом конце есть про ZFS

Vladislav

Vladislav

прошелся по ссылке, есть битые ссылки на инструкции

https://github.com/rsyuzyov/work-on-linux/blob/master/samba.md

George

George

в группе PostgreSQL + 1C + Linux, Роман отправлял уже ссылку, продублирую здесь:

https://github.com/rsyuzyov/work-on-linux

начать можно с неё, в самом конце есть про ZFS

Промахнулся с реплаем

Ставить 128k и не париться. Оно так по-умолчанию и стоит, к слову ;)ауч

Сергей

Сергей

прошелся по ссылке, есть битые ссылки на инструкции

https://github.com/rsyuzyov/work-on-linux/blob/master/samba.md

автор в той группе обитает, можно его там спросить)

Roman

Roman