а чего тогда в линукс дистрах от дискарда отказываются и рекомендуют трим ?

можно ссылку?

George

George

так линейноая запись, не ?

в общем у вас метод бенча странный. dd с 64МБ блоком != последовательная запись от приложения, плюс вы вообще io queue depth тут не учитываете

Ivan

Ivan

Note: Continuous TRIM is not the most preferred way to issue TRIM commands among the Linux community. For example, Ubuntu enables periodic TRIM by default [5], Debian does not recommend using continuous TRIM [6] and Red Hat recommends using periodic TRIM over using continuous TRIM if feasible. [7]

Ivan

Ivan

в общем понял. zfs всеравно будет писать меньшими блоками и не всегда последовательно. в таком разе мой днищессд утилизируется полностью

George

George

Note: Continuous TRIM is not the most preferred way to issue TRIM commands among the Linux community. For example, Ubuntu enables periodic TRIM by default [5], Debian does not recommend using continuous TRIM [6] and Red Hat recommends using periodic TRIM over using continuous TRIM if feasible. [7]

ну тут про регулярность речь то, а не про то что трим он же дискард вреден

Ivan

Ivan

в ядре есть исключения для некоторых ссд. даже если руками выставить постоянный дискард, ядро этого не сделает, инача ссд быстро зажмурится.

George

George

в общем понял. zfs всеравно будет писать меньшими блоками и не всегда последовательно. в таком разе мой днищессд утилизируется полностью

наоборот только обычно, в отличии от других ФС zfs будет по дефолту писать блоков 128КБ , а не 4 или 8 как большинство других

George

George

в ядре есть исключения для некоторых ссд. даже если руками выставить постоянный дискард, ядро этого не сделает, инача ссд быстро зажмурится.

ну если терроризировать тримом - да, это плохо

George

George

ммм, тада непонятно. скорость должна быть в 2 с небольшим раза выше.

не должна, тесты диска блоком 64МБ бессмысленны

Сергей

Сергей

а как я могу трим делать ? чет не соображу. т.к. обычно трим к точке монтирования привязан

а что вы хотите сделать?

Ivan

Ivan

Ivan

Ivan

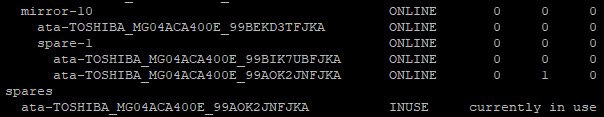

zpool remove rpool ata-TOSHIBA_MG04ACA400E_99AOK2JNFJKA

cannot remove ata-TOSHIBA_MG04ACA400E_99AOK2JNFJKA: root pool can not have removed devices, because GRUB does not understand them

Сергей

Сергей

zpool remove rpool ata-TOSHIBA_MG04ACA400E_99AOK2JNFJKA

cannot remove ata-TOSHIBA_MG04ACA400E_99AOK2JNFJKA: root pool can not have removed devices, because GRUB does not understand them

так ты пытаешься такой командой удалить уже диск в составе пула

Ivan

Ivan

zpool detach делал?

помогло

я руководствовался https://docs.oracle.com/cd/E53394_01/html/E54801/gpegp.html

Privetiq

Privetiq

Друзья, #вопрос : есть кластер из 3 нод. На двух ZFS (raid1) на третей LVM(soft raid1). насколько хорошо они будут дружить в LINStor? Стоит ли заморачиваться и заново разметить диски?

Один из серваков стоит под бекапы, второй для elasticsearch третий как продакшн web server на nginx. Еластик на LVM остальные на ZFS. Думал и прод на LVM перевести из-за производительности (имеется 2NVMe диска на проде).

Ivan

Ivan

Privetiq

Privetiq

мне посути нужно только между двумя нодами (на ссд и nvme дисках) держать реплику. Третий просто ежедневно на кроне создает потихоничку бекапчик в час ночи, и хранит у себя на всякий случай.

Vladislav

Vladislav

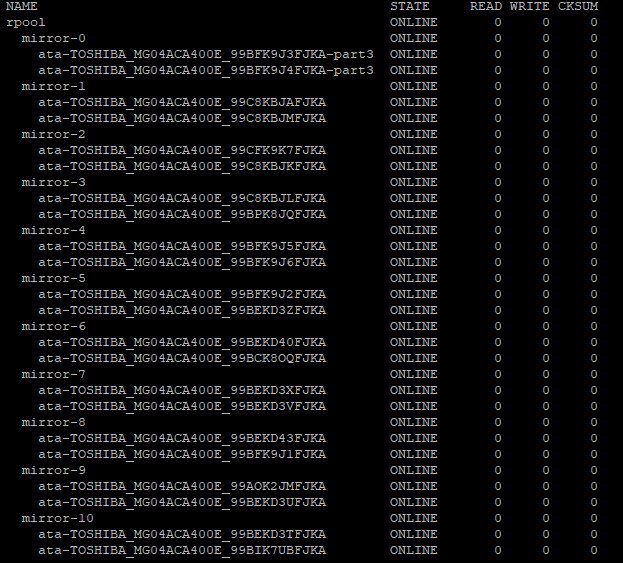

Имею сервер:

# camcontrol devlist

<HGST HUH721010ALE600 LHGNT384> at scbus0 target 0 lun 0 (ada0,pass0)

<HGST HUH721010ALE600 LHGNT384> at scbus1 target 0 lun 0 (ada1,pass1)

<HGST HUH721010ALE600 LHGNT384> at scbus2 target 0 lun 0 (ada2,pass2)

<HGST HUH721010ALE600 LHGNT384> at scbus3 target 0 lun 0 (ada3,pass3)

<AHCI SGPIO Enclosure 2.00 0001> at scbus6 target 0 lun 0 (ses0,pass4)

# zpool status zroot

pool: zroot

state: ONLINE

scan: none requested

config:

NAME STATE READ WRITE CKSUM

zroot ONLINE 0 0 0

mirror-0 ONLINE 0 0 0

gpt/system-ada0 ONLINE 0 0 0

gpt/system-ada1 ONLINE 0 0 0

gpt/system-ada2 ONLINE 0 0 0

gpt/system-ada3 ONLINE 0 0 0

errors: No known data errorsКак склонировать пул zroot на идентичное железо?

Vladislav

Vladislav

на ум приходит только:

1) риск режим целевой системы

2) копирование по ssh через dd раздела gpt/system-ada0 на первый диск нового сервера

Vladislav

Vladislav

далее импорт пула zroot, клонирование нового раздела на остальные три диска и добавление их в пул zroot

George

George

На принимающей стороне rescue или live cd поднять с zfs, создать новый пул, снапшотами zfs send recv

Vladislav

Vladislav

На принимающей стороне rescue или live cd поднять с zfs, создать новый пул, снапшотами zfs send recv

хотелось бы другого механизма

Vladislav

Vladislav

1) Создание скелета разделов (возможно по SSH удасться)

2) клонирование только пула ZFS (без данных)

George

George

1) Создание скелета разделов (возможно по SSH удасться)

2) клонирование только пула ZFS (без данных)

не понял, просто пустой пул создаёшь, корневые датасеты, а в них льёшь рекурсивно уже снапшоты

Сергей

Сергей

1) Создание скелета разделов (возможно по SSH удасться)

2) клонирование только пула ZFS (без данных)

так это будет не копия пула, а копия его структуры. Это полностью меняет первоначальный вопрос

Vladislav

Vladislav

не понял, просто пустой пул создаёшь, корневые датасеты, а в них льёшь рекурсивно уже снапшоты

это очень долго ручками

Мих

Мих