Сергей

Сергей

@ser_k, добрый день.

А что в итоге у вас получилось в части сбора статистики в разрезе датасетов?

Sergey

Sergey

@ser_k, добрый день.

А что в итоге у вас получилось в части сбора статистики в разрезе датасетов?

В инфе датасета есть id, по нему можно определить какой файл относится к конкретному датасету и там статистика для него

Сергей

Сергей

В инфе датасета есть id, по нему можно определить какой файл относится к конкретному датасету и там статистика для него

а какого рода статистика? только общее кол-во прочитанного/записанного? а есть ли деление на синхронную/асинхронную? по размерам блоков? Т.е. можно ли в итоге получить zpool iostat -q/-r в разрезе датасетов??

Сергей

Сергей

в разезе датасета я нашёл только в /proc/spl/kstat/zfs/zpool:

27 1 0x01 7 2160 6441575926 39110334523903

name type data

dataset_name 7 zpool/pg-rep-gcp/main

writes 4 99803945

nwritten 4 817400779358

reads 4 1539478

nread 4 12600888384

nunlinks 4 472

nunlinked 4 472

objset-0x18a (END)

Сергей

Сергей

Надеюсь это будут развивать и появится лейтенси и стата по блокам

этого и не хватает для оценки влияния параметров датасета на производительность

George

George

этого и не хватает для оценки влияния параметров датасета на производительность

на ходу - да, а так на тестовом пуле проверяется же отлично, когда в нём 1 датасет)

Сергей

Сергей

на ходу - да, а так на тестовом пуле проверяется же отлично, когда в нём 1 датасет)

нагрузку иногда сложно подать на тестовый аналогичную как на проде

Sergey

Sergey

Интересно нет тулзы которая может записать ио к файлам, накрайняк блочное, а потом воспроизвести его), как с траффиком из tcpdump)

Сергей

Сергей

Сергей

Сергей

я не знаю, вживую не пользовался ей. просто где-то на слуху было что её используют для профайлинга всех подсистем

Sergey

Sergey

Ну я говорю, тупо показать есть куча тулзов, а вот именно воспроизвести для теста - таких не знаю

Sergey

Sergey

https://linux.die.net/man/8/blktrace https://linux.die.net/man/8/btrecord

о, про блктрейс знал, а что есть воспроизводилка не знал, спасибо

George

George

о, про блктрейс знал, а что есть воспроизводилка не знал, спасибо

👍

у самого руки не доходят никак до них)

Sergey

Sergey

👍

у самого руки не доходят никак до них)

ага, у меня так же с zinject и мониторингом, никак не дойдут руки поэмулировать всякие проблемы и доделать)

Сергей

Сергей

nvme-KXD51RUE1T92_TOSHIBA_60DS10PIT sync_read sync_write async_read async_write

req_size ind agg ind agg ind agg ind agg

------------------------------------- ----- ----- ----- ----- ----- ----- ----- ----- -

512 0 0 0 0 0 0 0 0

1K 0 0 0 0 0 0 0 0

2K 0 0 0 0 0 0 0 0

4K 0 0 6 0 0 0 11 0

8K 4.12K 0 2 0 0 0 218 0

16K 20 0 42 0 0 0 21 130

32K 17 0 322 0 0 0 172 109

64K 0 0 323 6 0 0 17 157

128K 0 0 0 5 0 0 0 127

256K 0 0 0 0 0 0 0 0

@gmelikov, это iostat -r. Правильно ли я понимаю что ind и agg, это когда запросы не получилось сгруппировать и запрос был выполнен сразу? Большое кол-во ind против agg о чём может говорить? Нужно ли что-то тюнить чтобы agg стало больше чем ind?

George

George

nvme-KXD51RUE1T92_TOSHIBA_60DS10PIT sync_read sync_write async_read async_write

req_size ind agg ind agg ind agg ind agg

------------------------------------- ----- ----- ----- ----- ----- ----- ----- ----- -

512 0 0 0 0 0 0 0 0

1K 0 0 0 0 0 0 0 0

2K 0 0 0 0 0 0 0 0

4K 0 0 6 0 0 0 11 0

8K 4.12K 0 2 0 0 0 218 0

16K 20 0 42 0 0 0 21 130

32K 17 0 322 0 0 0 172 109

64K 0 0 323 6 0 0 17 157

128K 0 0 0 5 0 0 0 127

256K 0 0 0 0 0 0 0 0

@gmelikov, это iostat -r. Правильно ли я понимаю что ind и agg, это когда запросы не получилось сгруппировать и запрос был выполнен сразу? Большое кол-во ind против agg о чём может говорить? Нужно ли что-то тюнить чтобы agg стало больше чем ind?

https://openzfs.github.io/openzfs-docs/Performance%20and%20Tuning/ZFS%20on%20Linux%20Module%20Parameters.html#zfs-vdev-aggregation-limit

вот тут полезное чтиво на эту тему

Сергей

Сергей

Олег

Олег

Anonymous

Anonymous

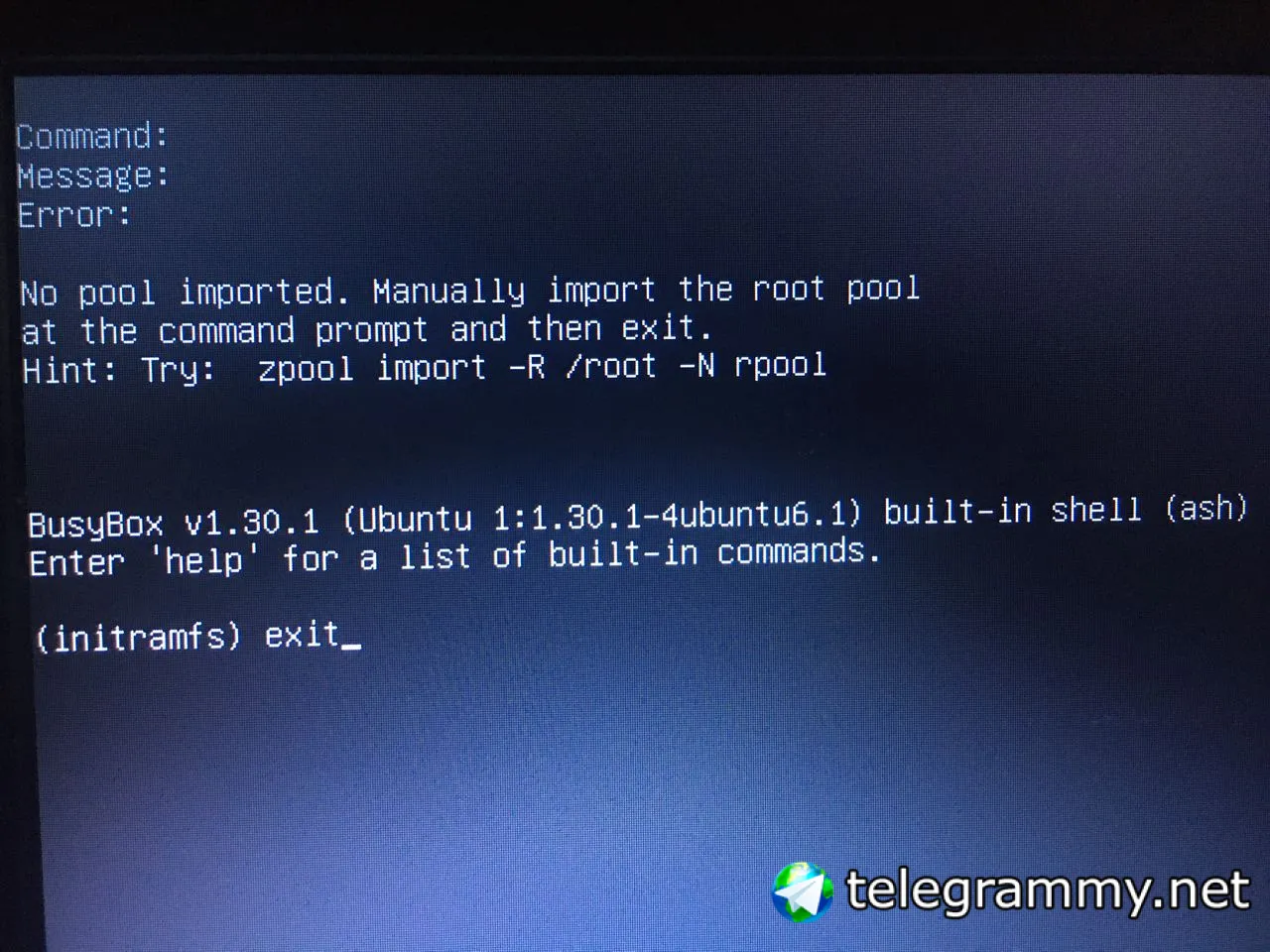

При загрузке пишет что нечего монтировать и вываливает в консоль. Пишу exit и дальше все норм грузится

Vladislav

Vladislav

Я решил таки заменить вылетевший винт на 3ТБ. Но не рассчитал время ресилверинга. Можно ли выключить сервер и через некоторое время включить для продолжения синхронизации данных? Пул не умрёт?

George

George

Вообще конечно, если резервирования больше нет - не стоит ребутиться, железо может при ребуте сдохнуть. А самому zfs пофиг, да.

Сергей

Сергей

запись на вдевы размазывается тоже. А вот с миррора только чтение увеличивается

вернусь сюда)). Получается что для raid 10 мы получаем увеличение скорости считывания в 4 раза (2x с каждого зеркала и ещё 2x с разных vdev)? А запись на raid10 будет только 2x (раз у нас 2 vdev)

George

George

вернусь сюда)). Получается что для raid 10 мы получаем увеличение скорости считывания в 4 раза (2x с каждого зеркала и ещё 2x с разных vdev)? А запись на raid10 будет только 2x (раз у нас 2 vdev)

ДО 4х раз на чтении на многопотоке, ДО 2х раз на многопоточной записи, верно

Vladislav

Vladislav

У меня какой-то клинч у системного пула....

https://pastebin.com/u03fpwmG

не знаю, как из него выходить

Vladislav

Vladislav

У меня какой-то клинч у системного пула....

https://pastebin.com/u03fpwmG

не знаю, как из него выходить

Похоже, помогли правки sysctl:

vfs.zfs.no_scrub_prefetch: 1

vfs.zfs.no_scrub_io: 1Пул стал проверяться очень живенько

Vladislav

Vladislav

1) что за OC ?

2) были ли обновления пакетов в системе?

3) Почитайте, какие текущие груб опции, как пример:

https://forum.proxmox.com/threads/zfs-boot-stuck-at-initramfs-no-root-device-specified.64147/post-314406

Ivan

Ivan

на тестовом сервере высокий io delay, сделал sync=disabeled и он упал почти до 0. потом решил вернуть sync=always, но io delay остался прежним. в чем нюанс ?

Сергей

Сергей

Ivan

Ivan

хотя вот запустил 2 параллельных бэкапа в вм, обычно один капитально клал io полностью, а тут сразу два вполне неплохо работают.

Сергей

Сергей

может быть что-то просралось и больше не тыркает диски.

может, лежал приличный объём для fsync в очереди

Yаroslav

Yаroslav

Здравствуйте. Подскажите пожалуйста как лучше организовать схд. Планируется к покупке X11SSM-F. Как лучше прокинуть диски в виртуалку, через встроенный контроллер или нужен HBA?

Владимир

Владимир

Здравствуйте. Подскажите пожалуйста как лучше организовать схд. Планируется к покупке X11SSM-F. Как лучше прокинуть диски в виртуалку, через встроенный контроллер или нужен HBA?

я думаю это не столь критично, но мне интересен ваш кейс. ЧТо за задача вынуждает пробрасывать диски внутрь виртуалки? ... Это без предъяв, просто интересно.

Владимир

Владимир

Кстати о пробросе дисков внутрь)), я с полмесяца назад прокидывал NVME внутрь виртуалки, и при включении виртуалки сервер ребутился)). ДИЧЬ))), не было времени вникать в проблему, решил тогда вопрос иным способом.

Fedor

Fedor

Кстати о пробросе дисков внутрь)), я с полмесяца назад прокидывал NVME внутрь виртуалки, и при включении виртуалки сервер ребутился)). ДИЧЬ))), не было времени вникать в проблему, решил тогда вопрос иным способом.

Видимо, было проброшено чуть больше, чем требовалось. Например, используемый системой компонент

Владимир

Владимир

Видимо, было проброшено чуть больше, чем требовалось. Например, используемый системой компонент

ну NVME не использовался системой никак. Вроде))

Владимир

Владимир

Хочу отойти от хардварного рейд и попробовать Zfs

тогда зачем пробрасывать в виртуалку, сделай ZFS на гипервизоре

Владимир

Владимир

Может, ты прокинул контроллер или часть шины :)

это делалось в торопях)), вероятно накосячил чего))

Yаroslav

Yаroslav

Да. Наверное средствами проксмокс создам. Но вопрос в следующем, родной контроллер на мп или LSI?

Yаroslav

Yаroslav

Будет ли разница в производительности? Контроллер бесит своей адской температуройи нужно колхозить кулер 40 мм

Владимир

Владимир

Ivan

Ivan

Будет ли разница в производительности? Контроллер бесит своей адской температуройи нужно колхозить кулер 40 мм

предлагаю потестировать. у меня на материнке банально не виделось более 2ТБ на дисках.

Yаroslav

Yаroslav

Ivan

Ivan

Оно не может и не должно уметь в GPT

шта ?

спокойно размечал диски в gpt, но места это не прибавило. более того, нельзя создать партицию за пределами 2 терабайт.

ivdok

ivdok

шта ?

спокойно размечал диски в gpt, но места это не прибавило. более того, нельзя создать партицию за пределами 2 терабайт.

Контроллер тупо не может аллоцировать за этими пределами, а если бы поддерживал спеку GPT - то это обязательно было бы реализовано.

Ivan

Ivan

вот странно, на гораздо более древнем железе таких проблем не видел с большими дисками. в gpt всегда виделось всё пространство.

Алексей

Алексей