Serge

Serge

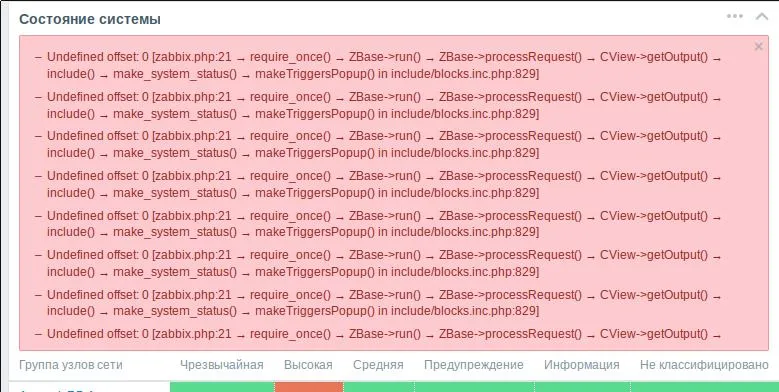

Как понял из куска кода, указанного в ошибке (include/blocks.inc.php:829), ошибка относится к таблице с последними событиями. Однако, эта таблица рисуется нормально и проблем с ней я не вижу

火影

火影

Коллеги, доброго времени суток. Подскажите, кто-то пытался реализовать передачу данных от одного Zabbix в другой через какую-либо MQ шину? Или от агентов напрямую в шину, чтобы сервер читал эти данные..

Juriy

Juriy

MQ?

https://ru.wikipedia.org/wiki/%D0%9E%D0%B1%D0%BC%D0%B5%D0%BD_%D1%81%D0%BE%D0%BE%D0%B1%D1%89%D0%B5%D0%BD%D0%B8%D1%8F%D0%BC%D0%B8

火影

火影

коллеги, дано: два сегмента сети, между которыми обмен данными может быть только(без вариантов) через ibm mq шину. пытаюсь придумать, как мне всё же консолидировать данные мониторинга zabbix в одном из сегментов

火影

火影

mq не предназначен для передачи данных

хотя если иметь в виду крупный массив данных от одного zbx в другой, то да. но вот агенты могли бы метрики сливать в шину…

火影

火影

он нужен для передачи сообщений, требующих реакции нескольких сервисов

это частный случай. elastic в enterprise прямо советует mq использовать (kafka), чтобы гарантировать доставку метрик и надёжнее объединить сегменты

Juriy

Juriy

коллеги, дано: два сегмента сети, между которыми обмен данными может быть только(без вариантов) через ibm mq шину. пытаюсь придумать, как мне всё же консолидировать данные мониторинга zabbix в одном из сегментов

в данном случае можно попробовать извартиться с двумя самодельными zproxy, один бы из которых принимал данные агентов и клал в MQ, а второй бы соотв-но вынимал и передавал в заббикс

火影

火影

но это тот еще костыль

угу, я надеялся, что у кого-то уже есть более человеческое решение.. без экскрементов и совсем чуть синей изоленты

Александр

Александр

Добрый день. Подскажите пожалуйста, есть элемент данных. Отдает либо "1" либо "0", мне нужно создать еще один элемент данных, точнее два, который будет показывать длительность срабатывания "1" и "0". Как реализовать такое, не понимаю. Помогите пожалуйста.

Juriy

Juriy

угу, я надеялся, что у кого-то уже есть более человеческое решение.. без экскрементов и совсем чуть синей изоленты

ну еще можно заказать работу чрез MQ самой конманде Заббикса :) они принимают коммерческие задачи

Juriy

Juriy

Коллеги, добрый день!

Кто-нибудь снимает метрики микросервисов со Spring Boot Actuator? Как вы это делаете?

Danil

Danil

Приветствую коллеги!

случилась такая проблема , необходимо получать трапы с портов коммутатора , и выводить определенную аварию при получение трапа с определенного порта.

Сделал правило обнаружения на первое событие - все ок , фильтрация по дескрипшену.

Делаю второе правило , с другим фильтром . вываливается ошибка "Элемент данных с ключом "snmptrap[.1.3.6.1.2.1.2.2.1.1.{#SNMPINDEX}]" уже существует у "DES1228""

火影

火影

коллеги, начну опрос отсюда. кто использует для своего #zabbix #postgresql, как вы добиваетесь ha баз?

Dmitry

Dmitry

火影

火影

о каких объемах идет речь

пока мы на этапе планирования и оцениваем по аналогам в других частях инфраструктуры.. ожидается что-то около 20к объектов мониторинга в прыжке и ~400 метрик на каждый объект... повторюсь - это на бумаге

火影

火影

и какой частоте вставке

с учётом того, что многие метрики будут поминутно собираться - я сегодня накалькулировал 133+к значений в секунду.

Dmitry

Dmitry

мы просто при достижении 10k m/s (20k устройств) уже слезли с заббикс, отсылали метрики в opentsdb для исторических данных

за место zabbix-server поставили демон-алерт-менеджер, который мог запоминать только предыдущее значение, триггерил сам клиент (riemann-like), а демон принемал решение сообщать админам или нет и если да то кому

火影

火影

мы просто при достижении 10k m/s (20k устройств) уже слезли с заббикс, отсылали метрики в opentsdb для исторических данных

за место zabbix-server поставили демон-алерт-менеджер, который мог запоминать только предыдущее значение, триггерил сам клиент (riemann-like), а демон принемал решение сообщать админам или нет и если да то кому

Я думаю, мы тоже вряд ли доживём до 20к девайсов с полноценными моделями здоровья именно в #zabbix, но до тех пор, чтобы выполнять заказы внутренних клиентов, надо как-то прожить, вот я и прикидываю, что заложить на первоначальном этапе, чтобы минимизировать вероятность факапа.. ha для db - один из вопросов

火影

火影

opentsdb + самописный демон на golang с какой-то in-memory db

а чому не хайповые прометей, инфлюкс, эластик?

Dmitry

Dmitry

и сколько у вас хрантся исторические данные?:

я уже ушел с проекта :) opentsdb хранит до сих пор - года 3-4

Александр

Александр

Коллеги, а avaya cs1000 кто-нибудь с заббиксом дружил по snmp?

Не-а. Найди MiB и мучай его, или через snmpwalk

Александр

Александр

инфу по загрузке CPU. Состоит из 4-х компонентов:

1.3.6.1.4.1.6889.2.8.1.6.11

# G3-AVAYA-MIB::g3healthStaticOcc.0 = Gauge32: 0

1.3.6.1.4.1.6889.2.8.1.6.12

# G3-AVAYA-MIB::g3healthCallpOcc.0 = Gauge32: 0

1.3.6.1.4.1.6889.2.8.1.6.13

# G3-AVAYA-MIB::g3healthSysMgmtOcc.0 = Gauge32: 3

1.3.6.1.4.1.6889.2.8.1.6.14

# G3-AVAYA-MIB::g3healthIdleOcc.0 = Gauge32: 97

Jenny

Jenny

Мне по сути состояние е1 интерфейсов нужно

дискавери на интерфейсы и прототипы айтемов на дискавери же

Dmitry

Dmitry

Дмитрий

Дмитрий

Гога

Гога